فناوری Deepfake می تواند سرگرم کننده باشد، اما پتانسیل آسیب رساندن آن قابل توجه است. در اینجا چیزی است که آینده دیپ فیک می تواند به همراه داشته باشد.

نشانههای گویای یک تصویر عمیق جعلی در گذشته به راحتی قابل تشخیص بود، اما هوش مصنوعی مولد ما را در مورد هر چیزی که اکنون میبینیم و میشنویم زیر سوال میبرد. با هر مدل هوش مصنوعی جدیدی که منتشر میشود، نشانههای گویای یک تصویر جعلی کاهش مییابد، و برای افزایش سردرگمی، اکنون میتوانید ویدیوهای دیپفیک، کلونهای صوتی از عزیزانتان را ایجاد کنید و مقالات جعلی را در عرض چند ثانیه بسازید.

برای اینکه فریب دیپفیکهای هوش مصنوعی را نخورید، ارزش این را دارد که بدانید آنها چه نوع خطراتی دارند.

تکامل دیپ فیکس

دیپ فیک شخصی را در حال انجام کاری نشان می دهد که هرگز در زندگی واقعی اتفاق نیفتاده است. کاملا جعلی است ما به دیپفیکها میخندیم که بهعنوان الگوی رفتاری یا شوخی در اینترنت به اشتراک گذاشته میشوند، اما تعداد کمی از مردم آن را خندهدار میبینند که از آنها برای گمراه کردن ما استفاده میشود.

در گذشته، دیپ فیک با گرفتن یک عکس موجود و تغییر آن در یک نرم افزار ویرایش تصویر مانند فتوشاپ ایجاد می شد. اما چیزی که یک دیپ فیک هوش مصنوعی را متمایز می کند این است که می توان آن را از ابتدا با استفاده از الگوریتم های یادگیری عمیق تولید کرد.

فرهنگ لغت مریام وبستر دیپ فیک را اینگونه تعریف می کند:

تصویر یا ضبطی که به طور قانعکنندهای تغییر یافته و دستکاری شده است تا کسی را نادرست نشان دهد که در حال انجام یا گفتن چیزی است که واقعاً انجام نشده یا گفته نشده است.

اما با پیشرفتهای فناوری هوش مصنوعی، این تعریف قدیمی به نظر میرسد. با استفاده از ابزارهای هوش مصنوعی، دیپ فیک اکنون شامل تصاویر، متن، ویدئوها و شبیه سازی صدا می شود. گاهی اوقات، هر چهار حالت تولید هوش مصنوعی به طور همزمان استفاده می شود.

از آنجایی که این یک فرآیند خودکار است که استفاده از آن فوقالعاده سریع و ارزان است، این ابزار عالی برای ایجاد دیپفیک با سرعتی است که قبلاً ندیدهایم – همه اینها بدون نیاز به دانستن یک چیز در مورد نحوه ویرایش عکسها، ویدیوها یا صدا .

خطرات بزرگ AI Deepfakes

مجموعه ای از تولید کننده های ویدئویی هوش مصنوعی در کنار تعداد زیادی از تولید کننده های صوتی هوش مصنوعی در حال حاضر وجود دارد. با استفاده از یک مدل زبان بزرگ مانند GPT-4، دستورالعملی برای ایجاد باورپذیرترین دیپ فیک هایی که تا کنون در تاریخ مدرن دیده ایم، خواهید داشت.

آگاهی از انواع مختلف دیپفیکهای هوش مصنوعی و نحوه استفاده از آنها برای فریب دادن شما، یکی از راههای جلوگیری از گمراه شدن است. در اینجا فقط چند نمونه جدی از اینکه چگونه فناوری دیپفیک هوش مصنوعی یک تهدید واقعی است، آورده شده است.

1. سرقت هویت هوش مصنوعی

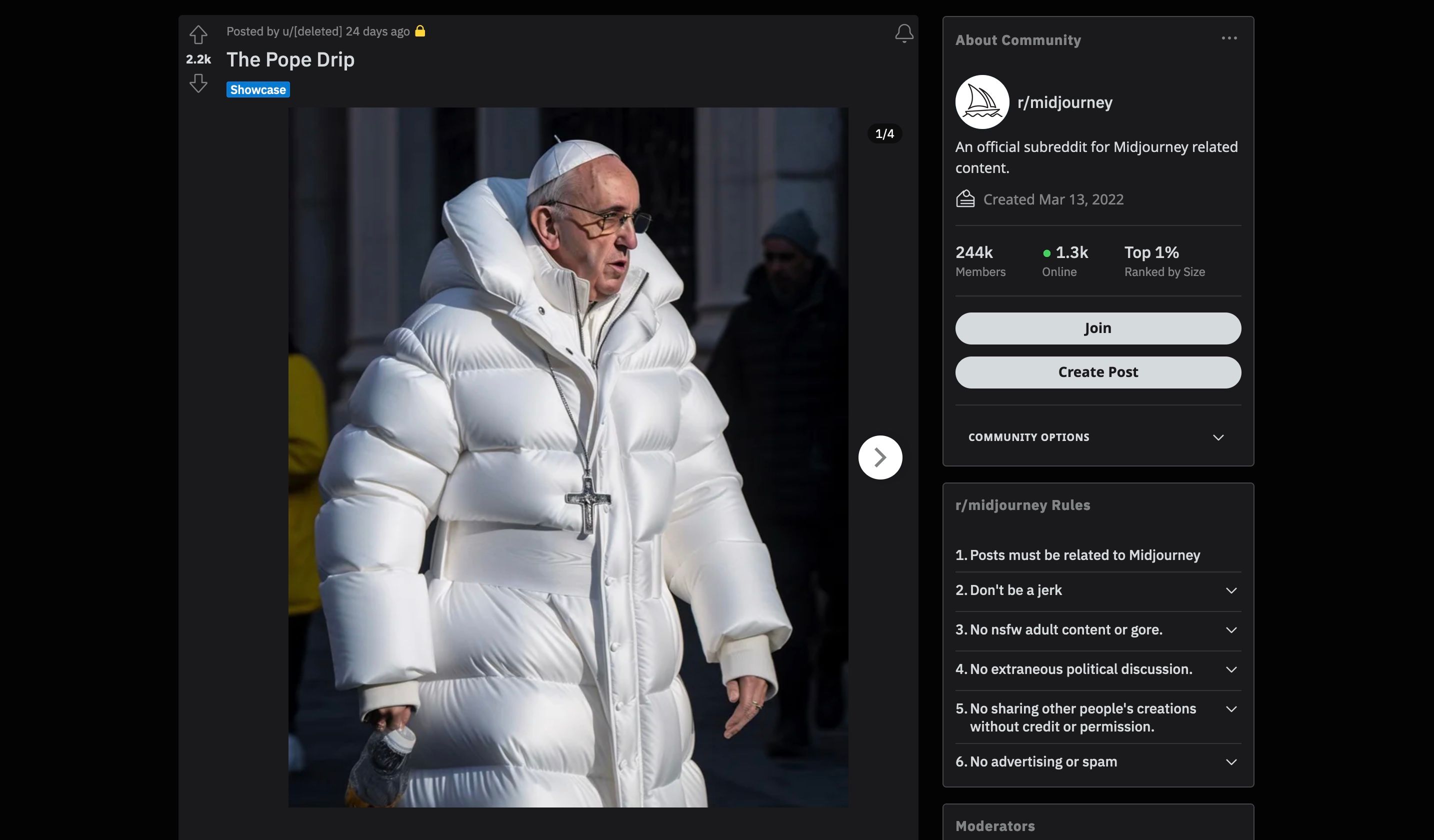

ممکن است آنها را دیده باشید. یکی از اولین دیپفیکهای واقعاً ویروسی هوش مصنوعی که در سراسر جهان پخش شد، تصویری از دستگیری دونالد ترامپ و یکی از پاپ فرانسیس با ژاکت پفی سفید بود.

در حالی که به نظر می رسد تصور مجدد بی گناهی از آنچه یک شخصیت مذهبی مشهور ممکن است در یک روز سرد در رم بپوشد. تصویر دیگر، نشان دادن یک شخصیت سیاسی در وضعیت جدی با قانون، اگر واقعی باشد، عواقب بسیار بیشتری دارد.

تا کنون، مردم عمدتاً افراد مشهور، شخصیتهای سیاسی و سایر افراد مشهور را هنگام ایجاد دیپفیکهای هوش مصنوعی هدف قرار دادهاند. تا حدی به این دلیل است که افراد مشهور عکس های زیادی از آنها در اینترنت دارند که احتمالاً در وهله اول به آموزش مدل کمک کرده است.

در مورد یک تولید کننده تصویر هوش مصنوعی مانند Midjourney – که هم در دیپ فیک ترامپ و هم پاپ استفاده می شود – کاربر به سادگی باید متنی را وارد کند که توصیف کننده آنچه می خواهد ببیند. از کلمات کلیدی می توان برای مشخص کردن سبک هنری استفاده کرد، مانند عکس یا فوتورئالیسم، و نتایج را می توان با افزایش وضوح وضوح تنظیم کرد.

شما به همین راحتی می توانید استفاده از Midjourney را یاد بگیرید و خودتان آن را آزمایش کنید، اما به دلایل اخلاقی و قانونی واضح، باید از ارسال عمومی این تصاویر خودداری کنید.

متأسفانه، یک انسان معمولی و غیر مشهور بودن، تضمینی نمیکند که شما در برابر دروغهای عمیق هوش مصنوعی در امان هستید.

مشکل در یک ویژگی کلیدی است که توسط تولیدکنندگان تصویر هوش مصنوعی ارائه شده است: توانایی آپلود تصویر خود و دستکاری آن با هوش مصنوعی. و ابزاری مانند Outpainting در DALL-E 2 میتواند با وارد کردن یک پیام متنی و توصیف آنچه میخواهید تولید کنید، تصویر موجود را فراتر از مرزهای آن گسترش دهد.

اگر قرار باشد شخص دیگری این کار را با عکسهای شما انجام دهد، خطرات آن میتواند به طور قابلتوجهی بیشتر از دیپ فیک پاپ با ژاکت سفید باشد – آنها میتوانند از آن در هر جایی استفاده کنند و وانمود کنند که شما هستند. در حالی که اکثر مردم عموماً از هوش مصنوعی با نیت خوب استفاده می کنند، محدودیت های بسیار کمی وجود دارد که افراد را از استفاده از آن برای آسیب رساندن باز می دارد، به خصوص در موارد سرقت هویت.

2. کلاهبرداری های کلون صوتی Deepfake

با کمک هوش مصنوعی، دیپفیکها از مرزی عبور کردهاند که اکثر ما برای آن آماده نبودیم: شبیهسازیهای صوتی جعلی. تنها با مقدار کمی صدای اصلی – شاید از یک ویدیوی TikTok که زمانی پست کردهاید، یا یک ویدیوی YouTube که در آن ظاهر میشوید – یک مدل هوش مصنوعی میتواند صدای یکوجهی شما را تکرار کند.

تصور اینکه یک تماس تلفنی شبیه یکی از اعضای خانواده، دوست یا همکار باشد، هم عجیب و هم ترسناک است. کلون های صوتی عمیق به اندازه کافی یک نگرانی جدی است که کمیسیون تجارت فدرال (FTC) در مورد آن هشداری صادر کرده است.

به صدا اعتماد نکن با فردی که ظاهراً با شما تماس گرفته تماس بگیرید و ماجرا را تأیید کنید. از شماره تلفنی استفاده کنید که می دانید مال آنهاست. اگر نمی توانید با عزیزتان تماس بگیرید، سعی کنید از طریق یکی دیگر از اعضای خانواده یا دوستانش با او در تماس باشید.

واشنگتن پست از موردی خبر داد که یک زن و شوهر در دهه 70 زندگی خود از کسی که صدایی شبیه نوه آنها داشت، تماس تلفنی دریافت کردند. او در زندان بود و برای وثیقه نیاز فوری به پول داشت. بدون اینکه هیچ دلیل دیگری برای شک داشتن با چه کسی صحبت می کنند، پیش رفتند و پول را به کلاهبردار تحویل دادند.

این تنها نسل قدیم نیست که در معرض خطر است، گاردین نمونه دیگری از یک مدیر بانکی را گزارش کرد که پس از یک سری “تماس های عمیق جعلی” از سوی فردی که معتقد بودند مدیر بانک است، تراکنش 35 میلیون دلاری را تایید کرد.

3. اخبار جعلی تولید انبوه

مدلهای زبان بزرگ، مانند ChatGPT، در تولید متنی که صدایی شبیه به انسان دارد، بسیار خوب هستند، و ما در حال حاضر ابزار مؤثری برای تشخیص تفاوت نداریم. در دستان نادرست، تولید اخبار جعلی و تئوریهای توطئه ارزان خواهد بود و مدت بیشتری طول میکشد تا افشا شود.

البته انتشار اطلاعات نادرست چیز جدیدی نیست، اما یک مقاله تحقیقاتی منتشر شده در arXiv در ژانویه 2023 توضیح می دهد که مشکل در این است که چگونه می توان خروجی را با ابزارهای هوش مصنوعی افزایش داد. آنها از آن به عنوان “کمپین های نفوذ تولید شده توسط هوش مصنوعی” یاد می کنند، که می گویند، برای مثال، سیاستمداران می توانند از آن برای برون سپاری کمپین های سیاسی خود استفاده کنند.

ترکیب بیش از یک منبع تولید شده توسط هوش مصنوعی یک دیپ فیک سطح بالا ایجاد می کند. به عنوان مثال، یک مدل هوش مصنوعی میتواند یک خبر خوب نوشتاری و قانعکننده ایجاد کند تا در کنار تصویر جعلی دستگیری دونالد ترامپ باشد. این به آن مشروعیت بیشتری نسبت به زمانی که تصویر به تنهایی به اشتراک گذاشته شده است، می دهد.

اخبار جعلی به تصاویر و نوشتهها نیز محدود نمیشود، پیشرفتها در تولید ویدیو با هوش مصنوعی به این معنی است که شاهد ظهور ویدیوهای عمیقفک بیشتری هستیم. در اینجا یکی از رابرت داونی جونیور است که به ویدیویی از ایلان ماسک پیوند زده شده است که توسط کانال YouTube Deepfakery ارسال شده است.

ایجاد یک دیپ فیک می تواند به سادگی دانلود یک برنامه باشد. میتوانید از برنامهای مانند TokkingHeads برای تبدیل تصاویر ثابت به آواتارهای متحرک استفاده کنید، که به شما امکان میدهد تصویر و صدای خود را آپلود کنید تا به نظر برسد که شخص در حال صحبت است.

در بیشتر موارد، سرگرم کننده و سرگرم کننده است، اما بالقوه برای دردسر نیز وجود دارد. این به ما نشان می دهد که چقدر آسان است که از تصویر هر کسی استفاده کنیم تا به نظر برسد که آن شخص کلماتی را به زبان آورده است که هرگز به زبان نیاورده است.

فریب یک AI Deepfake را نخورید

دیپفیکها را میتوان به سرعت با هزینه بسیار کم و با تخصص کم یا قدرت محاسباتی مورد نیاز به کار برد. آنها می توانند شکل یک تصویر تولید شده، یک کلون صوتی یا ترکیبی از تصاویر، صدا و متن تولید شده توسط هوش مصنوعی را داشته باشند.

قبلاً تولید دیپفیک بسیار سختتر و سختتر بود، اما اکنون، با وجود تعداد زیادی اپلیکیشن هوش مصنوعی، تقریباً هر کسی به ابزارهای مورد استفاده برای ایجاد دیپفیک دسترسی دارد. همانطور که فناوری دیپ فیک هوش مصنوعی هر چه بیشتر پیشرفته تر می شود، ارزش این را دارد که خطرات ناشی از آن را زیر نظر داشته باشید.