ChatGPT دیگر در ایتالیا در دسترس نیست، اما چرا؟

ChatGPT OpenAI به طور گسترده مورد تحسین قرار گرفته است – به ندرت سؤالی وجود دارد که ندیده باشیم به آن پاسخ دهد. با این حال، مجری ایتالیایی مقررات عمومی حفاظت از داده اتحادیه اروپا (GDPR) استفاده از ChatGPT در ایتالیا را به طور موقت و فوری تحریم کرده است.

این بدان معناست که اگر در ایتالیا هستید، اکنون نمی توانید از چت ربات هوش مصنوعی استفاده کنید. در اینجا دلیل آن است.

چرا ایتالیا ChatGPT را ممنوع کرد؟

در 30 مارس 2023، سازمان حفاظت از داده های ایتالیا، Garante per la Protezione dei Dati Personali (GPDP)، به طور رسمی ممنوعیت ChatGPT را اعلام کرد که بلافاصله اعمال می شود و تا زمانی که ChatGPT با GDPR اتحادیه اروپا مطابقت نداشته باشد، ادامه خواهد داشت.

رگولاتور داده ایتالیایی اعلام کرد که ChatGPT OpenAI چندین مشکل ایجاد کرده و قانون حریم خصوصی اتحادیه اروپا را نقض کرده است. نگرانی های مربوط به حریم خصوصی GDPD را می توان به پنج حوزه اصلی تقسیم کرد:

1. نقض قوانین حفظ حریم خصوصی

نگرانی اصلی GDPD این است که ChatGPT به پردازش داده های شخصی با نقض قوانین حفظ حریم خصوصی خود ادامه می دهد. اگرچه روش کار ChatGPT این است که قبل از استقرار آموزش دیده است، ربات چت همچنان داده های کاربران را برای ارائه پاسخ های مرتبط جمع آوری و پردازش می کند.

تنظیمکننده ایتالیایی تضمین میکند که کنترلکنندههای داده از تعهدات کلی مندرج در قانون حریم خصوصی اتحادیه اروپا پیروی میکنند و OpenAI کوتاهی میکند.

2. جمع آوری ناموجه از داده های شخصی

جدا از نقض قوانین حفظ حریم خصوصی، GDPD ادعا می کند که هیچ توجیه قانونی برای جمع آوری گسترده OpenAI و پردازش داده های شخصی برای آموزش الگوریتم های ChatGPT وجود ندارد. طبق گفته تنظیم کننده ایتالیایی، اطلاعات ChatGPT همیشه با شرایط واقعی مطابقت ندارد، بنابراین OpenAI می تواند از داده های شخصی جعلی استفاده کند.

3. عدم دسترسی آسان و شفاف اطلاعات

علاوه بر این، رگولاتور ایتالیایی اشاره کرد که OpenAI به کاربرانی که دادههای جمعآوری میکند اطلاع نمیدهد. این یکی دیگر از نقض آشکار قوانین حریم خصوصی اتحادیه اروپا است.

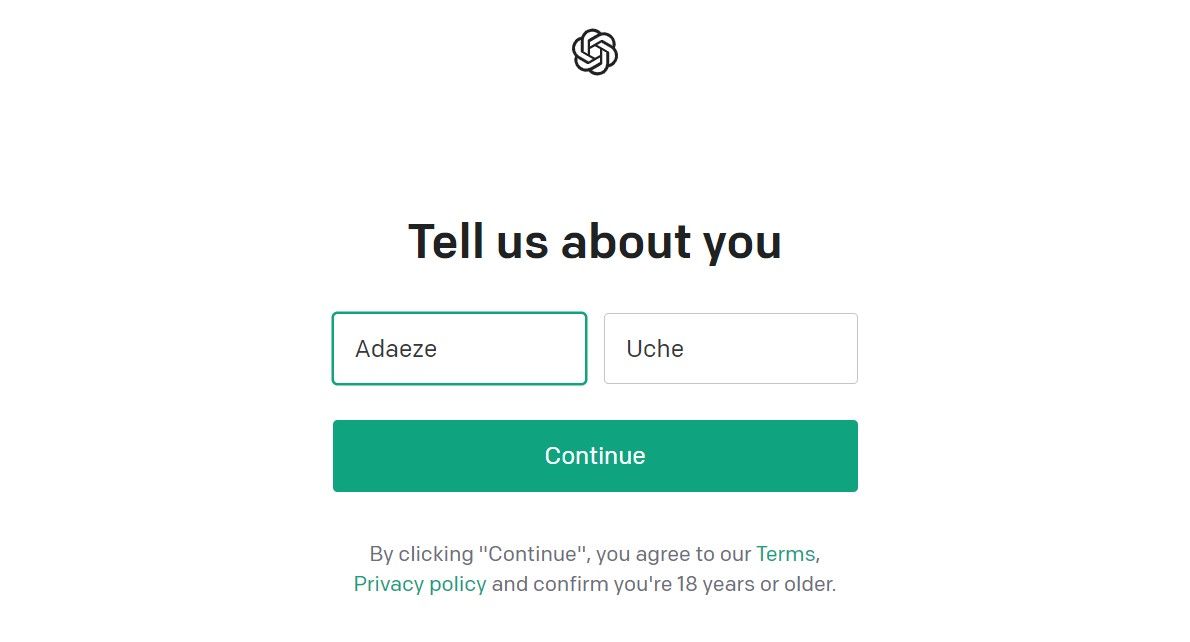

4. عدم وجود سیستم های تایید سن

GDPD اعلام کرد که ChatGPT اطلاعات نامناسبی را در اختیار کاربران زیر 13 سال قرار می دهد زیرا مکانیسم های تشخیص سن مناسب را ندارد. این قرار گرفتن در معرض افراد زیر سن قانونی ناقض GDPR اتحادیه اروپا است که بیان می کند افراد باید به طور واضح با پردازش داده های شخصی خود موافقت کنند. به عنوان افراد زیر سن قانونی، آنها نباید از طرف خود رضایت دهند.

5. خطر نقض داده ها

رگولاتور ایتالیایی در حالی که به نقض اطلاعات گزارش شده در 20 مارس 2023 اشاره می کند، نگرانی هایی را در مورد خطر نقض داده ها توسط ربات چت مطرح کرد. اعلام یوروپل در مورد پتانسیل مجرمانی که از ChatGPT برای ارتکاب کلاهبرداری و جرایم سایبری استفاده می کنند احتمالاً این نگرانی ها را تقویت کرده است.

نقض داده ها همچنین قوانین حریم خصوصی کشور را نقض می کند – همه پردازشگرهای داده باید اقدامات امنیتی مناسب را اجرا کنند.

ممنوعیت ChatGPT ایتالیا می تواند الگویی برای سایر کشورهای اتحادیه اروپا باشد

گفته می شود GDPR اتحادیه اروپا سخت ترین قانون حفظ حریم خصوصی در جهان است و ممنوعیت ایتالیا بر اهمیت رعایت داده ها در اروپا تأکید دارد. گزارش شده است که اداره اطلاعات ایرلند در حال مطالعه اقدامات GDPD با قصد “هماهنگی” با اتحادیه اروپا در مورد این ممنوعیت است. به همین ترتیب، گفته میشود که تنظیمکننده داده بریتانیا از هوش مصنوعی با شرط رعایت قوانین حفاظت از دادهها حمایت میکند.

اگرچه ممنوعیت ChatGPT ایتالیا جامع است، اما گفته می شود که موقتی است. Garante per la Protezione dei Dati Personali درخواست اطلاعیه ای از OpenAI در مورد جزئیات اقدامات انجام شده برای پیروی از دستورات خود کرده است. اگر OpenAI رعایت نکند، این ممنوعیت میتواند دائمی شود، مانند ممنوعیت ایتالیا در Replika، یکی دیگر از رباتهای چت هوش مصنوعی. OpenAI همچنین احتمالاً 20 میلیون یورو یا 4 درصد از گردش مالی سالانه جهانی خود را پرداخت خواهد کرد.

ممنوعیت ChatGPT ایتالیا می تواند انطباق داده های هوش مصنوعی جهانی را بهبود بخشد یا مانع رشد سریع چت ربات هوش مصنوعی شود. در هر صورت، این ممنوعیت پیامدهای مهمی برای ChatGPT خواهد داشت.