شرکتهای بیشتری ChatGPT را در محل کار ممنوع میکنند، اما چه چیزی پشت این ممنوعیتها وجود دارد؟

با وجود توانایی های چشمگیر آن، چندین شرکت بزرگ کارمندان خود را از استفاده از ChatGPT منع کرده اند.

در ماه مه 2023، سامسونگ استفاده از ChatGPT و دیگر ابزارهای مولد هوش مصنوعی را ممنوع کرد. سپس، در ژوئن 2023، بانک مشترک المنافع استرالیا، همراه با شرکت هایی مانند آمازون، اپل، و JPMorgan Chase & Co. برخی بیمارستان ها، شرکت های حقوقی، و سازمان های دولتی نیز کارمندان خود را از استفاده از ChatGPT منع کردند.

بنابراین، چرا شرکتهای بیشتری ChatGPT را ممنوع میکنند؟ در اینجا پنج دلیل عمده وجود دارد.

1. نشت داده ها

ChatGPT برای آموزش و عملکرد مؤثر به حجم زیادی از داده نیاز دارد. چت بات با استفاده از حجم عظیمی از داده های مشتق شده از اینترنت آموزش داده شد و آموزش آن همچنان ادامه دارد.

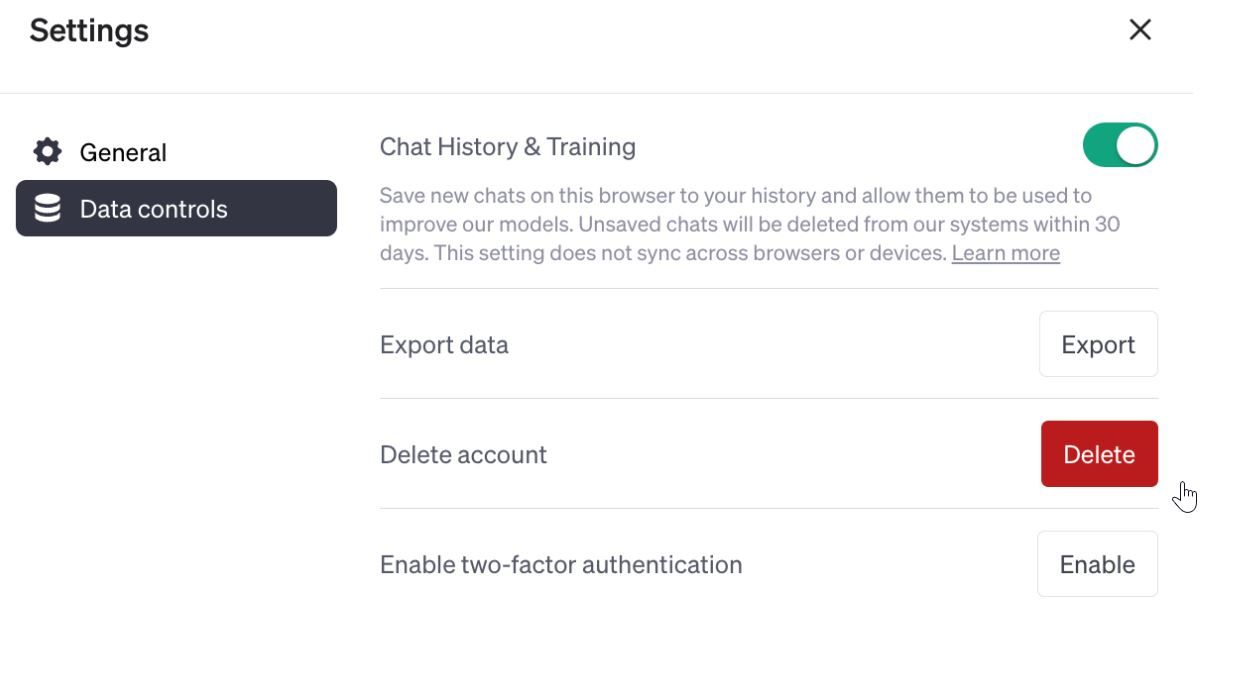

طبق صفحه راهنمای OpenAI، هر بخش از دادهها، از جمله جزئیات محرمانه مشتری، اسرار تجاری، و اطلاعات تجاری حساسی که به چت ربات میدهید، توسط مربیان آن قابل بررسی است که ممکن است از دادههای شما برای بهبود سیستمهای خود استفاده کنند.

بسیاری از شرکت ها مشمول مقررات سختگیرانه حفاظت از داده ها هستند. در نتیجه، آنها در مورد به اشتراک گذاری داده های شخصی با نهادهای خارجی محتاط هستند، زیرا این امر خطر نشت داده ها را افزایش می دهد.

علاوه بر این، OpenAI هیچ گونه حفاظت از داده ها و تضمین محرمانه بودن را ارائه نمی دهد. در مارس 2023، OpenAI اشکالی را تأیید کرد که به برخی از کاربران اجازه میداد عناوین چت را در تاریخچههای سایر کاربران فعال مشاهده کنند. اگرچه این باگ برطرف شد و OpenAI یک برنامه پاداش باگ راه اندازی کرد، این شرکت امنیت و حریم خصوصی داده های کاربر را تضمین نمی کند.

بسیاری از سازمانها ترجیح میدهند کارمندان را از استفاده از ChatGPT محدود کنند تا از نشت دادهها جلوگیری کنند، که میتواند به اعتبار آنها آسیب برساند، منجر به زیانهای مالی شود و مشتریان و کارمندان خود را در معرض خطر قرار دهد.

2. خطرات امنیت سایبری

در حالی که مشخص نیست که ChatGPT واقعاً مستعد خطرات امنیت سایبری است یا خیر، این احتمال وجود دارد که استقرار آن در یک سازمان ممکن است آسیبپذیریهای بالقوهای را ایجاد کند که مهاجمان سایبری میتوانند از آنها سوء استفاده کنند.

اگر شرکتی ChatGPT را ادغام کند و در سیستم امنیتی چت بات ضعف هایی وجود داشته باشد، مهاجمان ممکن است بتوانند از آسیب پذیری ها سوء استفاده کرده و کدهای بدافزار را تزریق کنند. همچنین، توانایی ChatGPT برای ایجاد پاسخهایی شبیه به انسان، تخم طلایی برای مهاجمان فیشینگ است که میتوانند یک حساب کاربری را تصاحب کنند یا با جعل هویت نهادهای قانونی، کارکنان شرکت را فریب دهند تا اطلاعات حساس را به اشتراک بگذارند.

3. ایجاد چت ربات های شخصی

ChatGPT با وجود ویژگیهای نوآورانهاش، میتواند اطلاعات نادرست و گمراهکننده تولید کند. در نتیجه، بسیاری از شرکت ها چت ربات های هوش مصنوعی را برای اهداف کاری ایجاد کرده اند. به عنوان مثال، بانک مشترک المنافع استرالیا از کارمندان خود خواست تا به جای آن از Gen.ai استفاده کنند، یک ربات چت هوش مصنوعی (AI) که از اطلاعات CommBank برای ارائه پاسخ استفاده می کند.

شرکتهایی مانند سامسونگ و آمازون مدلهای پیشرفته زبان طبیعی را توسعه دادهاند، بنابراین کسبوکارها میتوانند به راحتی چتباتهای شخصیسازیشده را بر اساس رونوشتهای موجود ایجاد و استقرار دهند. با استفاده از این رباتهای گفتگوی داخلی، میتوانید از عواقب حقوقی و اعتباری مرتبط با سوء استفاده از دادهها جلوگیری کنید.

4. فقدان مقررات

در صنایعی که شرکتها مشمول پروتکلهای نظارتی و تحریمها هستند، فقدان دستورالعملهای نظارتی ChatGPT یک پرچم قرمز است. بدون شرایط دقیق نظارتی حاکم بر استفاده از ChatGPT، شرکت ها می توانند هنگام استفاده از چت ربات هوش مصنوعی برای عملیات خود با عواقب قانونی شدیدی مواجه شوند.

علاوه بر این، فقدان مقررات می تواند مسئولیت پذیری و شفافیت شرکت را کاهش دهد. اکثر شرکت ها ممکن است در توضیح فرآیندهای تصمیم گیری و اقدامات امنیتی مدل زبان هوش مصنوعی برای مشتریان خود دچار سردرگمی شوند.

شرکت ها ChatGPT را محدود می کنند، زیرا از نقض احتمالی قوانین حفظ حریم خصوصی و مقررات خاص صنعت می ترسند.

5. استفاده غیر مسئولانه توسط کارکنان

در بسیاری از شرکت ها، برخی از کارمندان برای تولید محتوا و انجام وظایف خود تنها به پاسخ های ChatGPT متکی هستند. این باعث تنبلی در محیط کار می شود و خلاقیت و نوآوری را تقویت می کند.

وابسته بودن به هوش مصنوعی می تواند مانع از توانایی شما در تفکر انتقادی شود. همچنین میتواند به اعتبار یک شرکت آسیب برساند، زیرا ChatGPT اغلب دادههای نادرست و غیر قابل اعتماد ارائه میدهد.

اگرچه ChatGPT یک ابزار قدرتمند است، اما استفاده از آن برای پاسخگویی به سوالات پیچیده که نیاز به تخصص دامنه خاص دارند، می تواند به عملکرد و کارایی شرکت آسیب برساند. برخی از کارمندان ممکن است به یاد نداشته باشند که پاسخ های ارائه شده توسط ربات چت هوش مصنوعی را بررسی و تأیید کنند، و پاسخ ها را به عنوان یک راه حل یک اندازه در نظر بگیرند.

برای کاهش مشکلاتی از این قبیل، شرکت ها ممنوعیت هایی را روی ربات چت قرار می دهند تا کارمندان بتوانند روی وظایف خود تمرکز کنند و راه حل های بدون خطا را برای کاربران ارائه دهند.

ممنوعیت های ChatGPT: ایمن تر از متاسف شدن است

شرکتهایی که ChatGPT را ممنوع کردهاند، خطرات امنیت سایبری، استانداردهای اخلاقی کارکنان و چالشهای مربوط به رعایت مقررات را نشان میدهند. ناتوانی ChatGPT در کاهش این چالشها در حین ارائه راهحلهای صنعتی، محدودیتهای آن و نیاز به تکامل بیشتر را تأیید میکند.

در این میان، شرکتها به سمت چتباتهای جایگزین روی میآورند یا به سادگی کارمندان را از استفاده از ChatGPT محدود میکنند تا از نقض احتمالی دادهها و پروتکلهای امنیتی و نظارتی غیرقابل اعتماد مرتبط با ربات چت جلوگیری کنند.