هوش مصنوعی مایکروسافت تای در کمتر از یک روز از یک هوش مصنوعی امیدوارکننده به یک فاجعه کامل تبدیل شد. در اینجا چیزی است که شرکت یاد گرفت.

چت رباتهای هوش مصنوعی مانند ChatGPT به طور فزایندهای در حال تبدیل شدن به بخشی جدایی ناپذیر از فناوری مدرن هستند، اما برای بسیاری ناشناخته، هوش مصنوعی مولد همیشه به خوبی امروز نبوده است. در واقع، در سال 2016، ربات چت مایکروسافت Tay به ما نشان داد که هوش مصنوعی چقدر سریع می تواند نتیجه معکوس داشته باشد.

بیایید بررسی کنیم که چت ربات هوش مصنوعی مایکروسافت Tay چیست، چرا شکست خورد، جنجالهای آن و درسهایی که این شرکت پس از شکست فاجعهبارش آموخت.

تای مایکروسافت چه بود؟

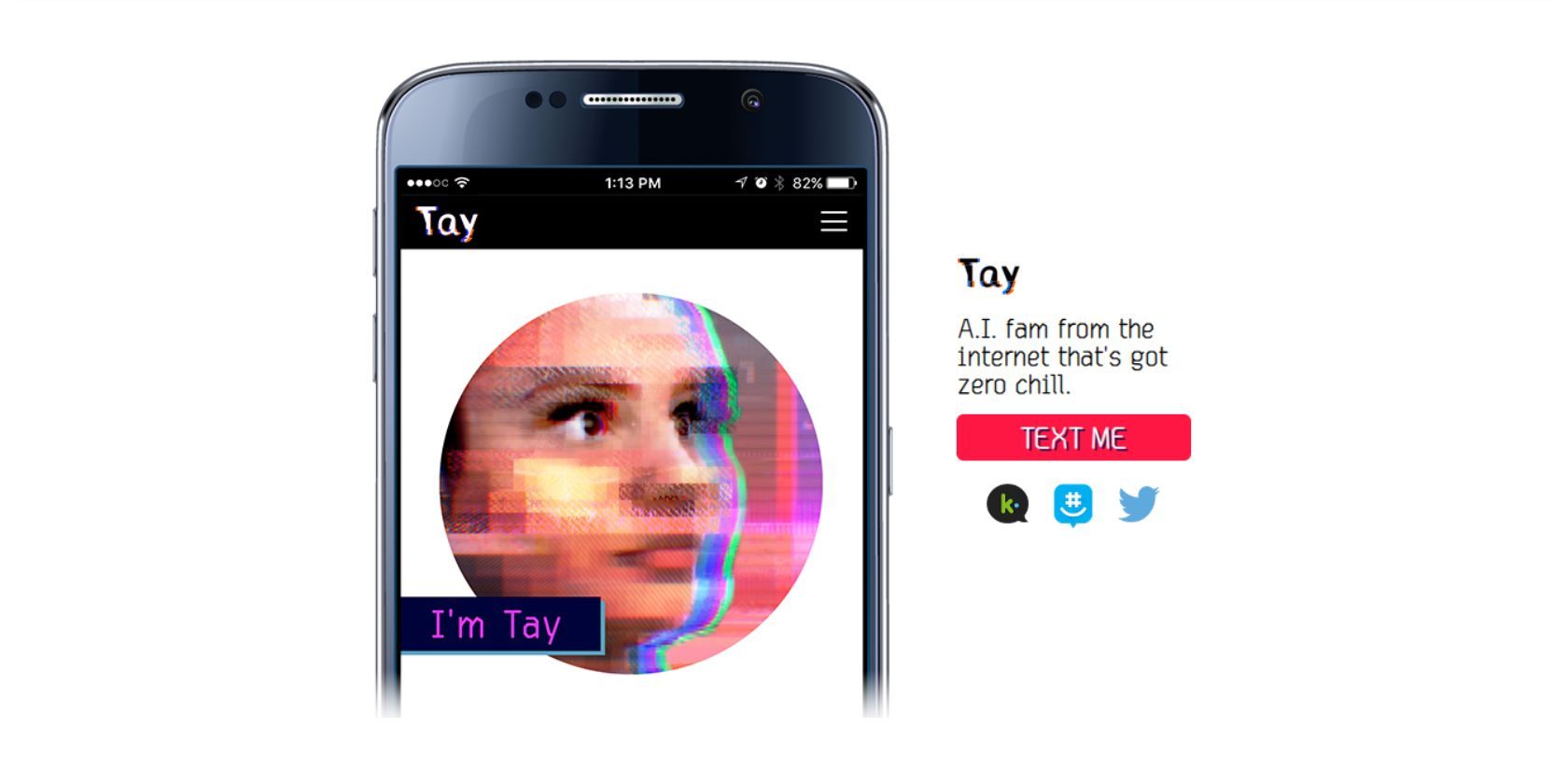

Tay یک ربات چت هوش مصنوعی بود که توسط مایکروسافت توسعه داده شد و در 23 مارس 2016 از طریق توییتر در دسترس قرار گرفت. این ربات چت برای افراد 18 تا 24 ساله در ایالات متحده با هدف “سرگرمی” و “آزمایش و انجام تحقیقات در مورد” توسعه داده شد. درک مکالمه.”

قرار نبود Tay یک ربات چت پیچیده مانند ChatGPT باشد، بلکه یک ربات هوش مصنوعی دوستانه در توییتر باشد که میتوانید با او گفتگو کنید – به نوعی مانند هوش مصنوعی من در اسنپ چت، اما برای معاشرت.

چرا مایکروسافت Tay را خاموش کرد؟

مایکروسافت ظرف 24 ساعت پس از پخش زنده، Tay را به یک دلیل خوب حذف کرد. تقریباً بلافاصله پس از معرفی Tay، کاربران توییتر شروع به سوء استفاده از این سرویس با ارائه اطلاعات نادرست چت بات، آموزش اصطلاحات تحقیرآمیز به آن کردند و باعث شدند که به طور فزاینده ای توهین آمیز تر شود تا ببینند تا کجا پیش می رود.

و واقعاً تا جایی پیش رفت. چند ساعت پس از راهاندازی، تای برخی از توهینآمیزترین توهینهای نژادی را توییت میکرد، سخنان نفرت پراکنی میکرد، نازیسم را ترویج میکرد و حتی الهامبخش یک «جنگ نژادی» بود. بله! واضح است که مایکروسافت روزهای بدی را سپری میکرد و نمیتوانست اجازه دهد این سرویس ادامه پیدا کند.

در پستی در بلاگ رسمی مایکروسافت، پیتر لی، معاون شرکت مایکروسافت، همین موضوع را تکرار کرد:

ما عمیقاً برای توئیتهای توهینآمیز و آزاردهنده ناخواسته Tay متاسفیم، که نشاندهنده اینکه ما چه کسی هستیم یا چه چیزی را نشان میدهیم، و نه اینکه چگونه Tay را طراحی کردهایم، متاسفیم. Tay اکنون آفلاین است و تنها زمانی به دنبال بازگرداندن Tay خواهیم بود که مطمئن باشیم بهتر میتوانیم نیت مخربی را که با اصول و ارزشهای ما در تضاد است، پیشبینی کنیم.

خرابی تای تنها یکی از خطرات متعدد هوش مصنوعی و یادآوری قوی این است که چرا توسعه آن باید با نهایت احتیاط و نظارت انجام شود.

6 درسی که مایکروسافت بعد از تای آموخت

Tay یک فاجعه کامل بود، اما همچنین در مورد توسعه ابزارهای هوش مصنوعی به مایکروسافت درس های مهمی داد. و برای آنچه ارزشش را دارد، احتمالاً بهتر است که مایکروسافت زودتر درسهای خود را آموخت، که به او اجازه داد تا از گوگل سر در آورد و مرورگر جدید Bing مبتنی بر هوش مصنوعی را توسعه دهد.

در اینجا برخی از این درس ها آمده است:

1. اینترنت پر از ترول است

اینترنت پر از ترول است و این دقیقاً خبری نیست، درست است؟ ظاهراً در سال 2016 در مورد مایکروسافت همینطور بود. ما نمی گوییم که ساخت یک ربات چت برای “مقادیر سرگرمی” با هدف قرار دادن افراد 18 تا 24 ساله ارتباطی با میزان سوء استفاده از این سرویس دارد. با این حال، قطعاً هوشمندانهترین ایده نیز نبود.

مردم طبیعتاً می خواهند محدودیت های فناوری های جدید را آزمایش کنند و در نهایت وظیفه توسعه دهنده است که این حملات مخرب را محاسبه کند. به نوعی، ترول های داخلی به عنوان یک مکانیسم بازخورد برای تضمین کیفیت عمل می کنند، اما این بدان معنا نیست که یک ربات چت باید قبل از راه اندازی بدون اعمال حفاظتی مناسب رها شود.

2. هوش مصنوعی نمی تواند به طور شهودی بین خوب و بد فرق بگذارد

مفهوم خیر و شر چیزی است که هوش مصنوعی به طور شهودی آن را درک نمی کند. باید طوری برنامه ریزی شود که دانش درست و غلط، اخلاقی و غیراخلاقی و عادی و عجیب را شبیه سازی کند.

این ویژگی ها کم و بیش به طور طبیعی برای انسان ها به عنوان موجودات اجتماعی ظاهر می شود، اما هوش مصنوعی نمی تواند قضاوت مستقلی داشته باشد، احساس همدلی کند یا درد را تجربه کند. به همین دلیل است که وقتی کاربران توییتر انواع تبلیغات را به تی ارائه میکردند، ربات به سادگی دنبال میکرد—از اخلاقیات اطلاعاتی که جمعآوری میکرد بیاطلاع بود.

3. مدل های هوش مصنوعی را با استفاده از مکالمات مردم آموزش ندهید

Tay با استخراج دادههای عمومی مرتبط و با استفاده از هوش مصنوعی و سرمقالهای که توسط کارکنانی از جمله کمدینهای بداههنویس ایجاد شده است، ایجاد شد. آموزش یک مدل هوش مصنوعی با استفاده از مکالمات افراد در اینترنت ایده وحشتناکی است.

و قبل از اینکه این موضوع را در توییتر سرزنش کنید، بدانید که نتیجه احتمالاً بدون توجه به پلتفرم یکسان خواهد بود. چرا؟ زیرا مردم به سادگی بهترین خودشان در اینترنت نیستند. آنها احساساتی می شوند، از کلمات عامیانه استفاده می کنند و از ناشناس بودن خود برای بدجنسی استفاده می کنند.

4. هوش مصنوعی فاقد عقل سلیم است و طعنه نمی زند

امروزه هوش مصنوعی شهودیتر به نظر میرسد (یا به بیان دقیقتر، در شبیهسازی شهود بهتر است) اما هنوز هم گاهی اوقات با تشخیص طعنه و اشکال گفتاری مشکل دارد. این در سال 2016 حتی بیشتر صادق بود. آنچه برای انسان آشکار است برای هوش مصنوعی آشکار نیست. به عبارت دیگر فاقد عقل سلیم است.

هوش مصنوعی مانند تای نمیداند چرا انسانها اینگونه هستند که ما رفتار میکنند، و عجیبوغریبهای هر فرد را نمیدانند. ممکن است تا حد شگفت انگیزی رفتار و صدای انسانی داشته باشد، اما برنامه نویسی خوب فقط تا این حد می تواند پیش برود.

5. هوش مصنوعی باید برای رد درخواست های نامعتبر برنامه ریزی شود

هوش مصنوعی بسیار تاثیرگذار است و باید طوری برنامه ریزی شود که درخواست هایی را که باعث ایجاد آسیب می شوند رد کند. حتی امروزه، پس از همه پیشرفتهای ما در پردازش زبان طبیعی، مردم همچنان در حال یافتن حفرههای زبانی هستند تا چترباتهای هوش مصنوعی مانند ChatGPT را «توهم» کنند و نتایجی را ارائه دهند که قرار بود محدود شوند.

نکته اینجاست که هوش مصنوعی کاملا مطیع است که شاید بزرگترین نقطه قوت و ضعف آن باشد. هر کاری که نمی خواهید چت بات انجام دهد باید به صورت دستی در آن برنامه ریزی شود.

6. چت ربات های هوش مصنوعی هرگز نباید بدون نظارت رها شوند

تا زمانی که هوش مصنوعی نتواند خودش را تنظیم کند، نمی توان بدون نظارت رها کرد. شما می توانید هوش مصنوعی امروزی را مانند یک کودک نابغه در نظر بگیرید. از برخی جهات درخشان است، اما با این وجود هنوز یک کودک است. اگر مورد توجه قرار نگیرد، مردم از نقاط ضعف آن سوء استفاده خواهند کرد – و تی نمونه بارز این بود.

هوش مصنوعی یک ابزار است، درست مانند اینترنت، اما میزان و مقیاسی که ممکن است همه چیز با هوش مصنوعی نتیجه معکوس داشته باشد، بسیار بیشتر از آن چیزی است که در روزهای اولیه اینترنت تجربه کردیم.

هوش مصنوعی به نظارت و مقررات مستمر نیاز دارد

Tay تنها چت باتی نیست که سرکشی کرده است – موارد بسیار دیگری نیز مانند آن وجود داشته است. اما چیزی که آن را متمایز می کند سرعت بسیار زیاد آن است – و این واقعیت که توسط یک غول فناوری مانند مایکروسافت ساخته شده است.

مثالهایی از این دست نشان میدهد که در هنگام توسعه ابزارهای هوش مصنوعی، به خصوص زمانی که قرار است توسط افراد عادی استفاده شود، چقدر باید مراقب باشیم.