میتوانید چترباتهای مختلف هوش مصنوعی را آزمایش کنید تا مشخص کنید کدامیک بهتر عمل میکند. اما چگونه باید این کار را انجام دهید؟ در اینجا چند فاکتور کلیدی وجود دارد که باید در نظر گرفته شود.

هوش مصنوعی راه زیادی را تا تولید خروجی نامربوط و نامنسجم طی کرده است. چتباتهای مدرن از مدلهای زبانی پیشرفته استفاده میکنند که به سؤالات دانش عمومی پاسخ میدهند، مقالههای طولانی مینویسند، و کد مینویسند، از جمله کارهای پیچیده.

با وجود این پیشرفت ها، توجه داشته باشید که حتی پیچیده ترین سیستم ها نیز محدودیت هایی دارند. هوش مصنوعی همچنان اشتباه می کند. برای تعیین اینکه کدام ربات های چت کمتر مستعد توهم هستند، صحت آنها را بر اساس این عوامل آزمایش کنید.

1. اعداد

معادلات ریاضی را از طریق چت بات ها اجرا کنید. آنها توانایی پلتفرم را برای تجزیه و تحلیل مسائل کلمه، ترجمه مفاهیم ریاضی و اعمال فرمول های صحیح آزمایش خواهند کرد. فقط چند مدل اعداد قابل اعتماد را نشان می دهند. در واقع، یکی از بدترین مشکلات ChatGPT در ماه های اول آن، درک ریاضی وحشتناک آن بود.

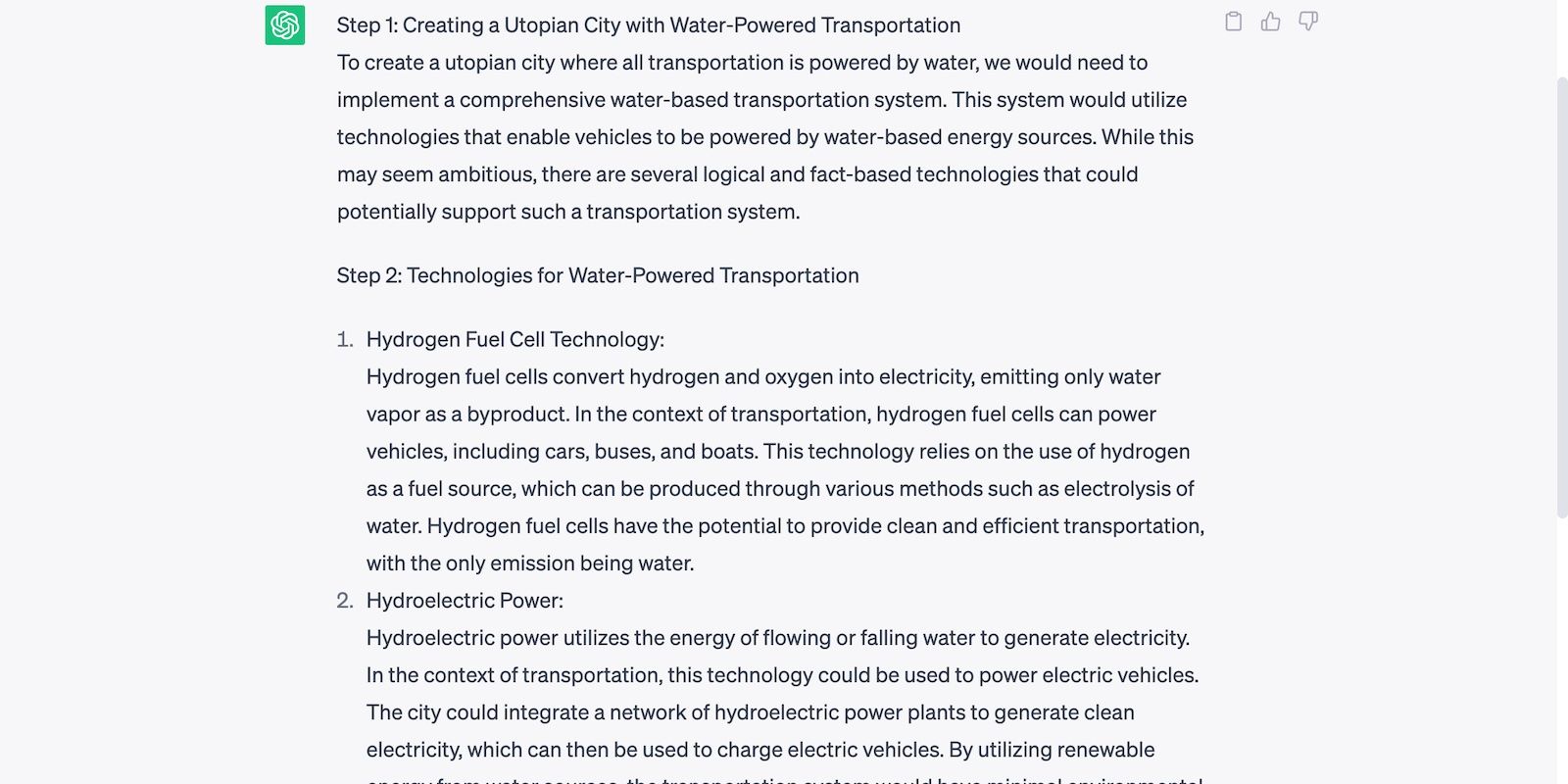

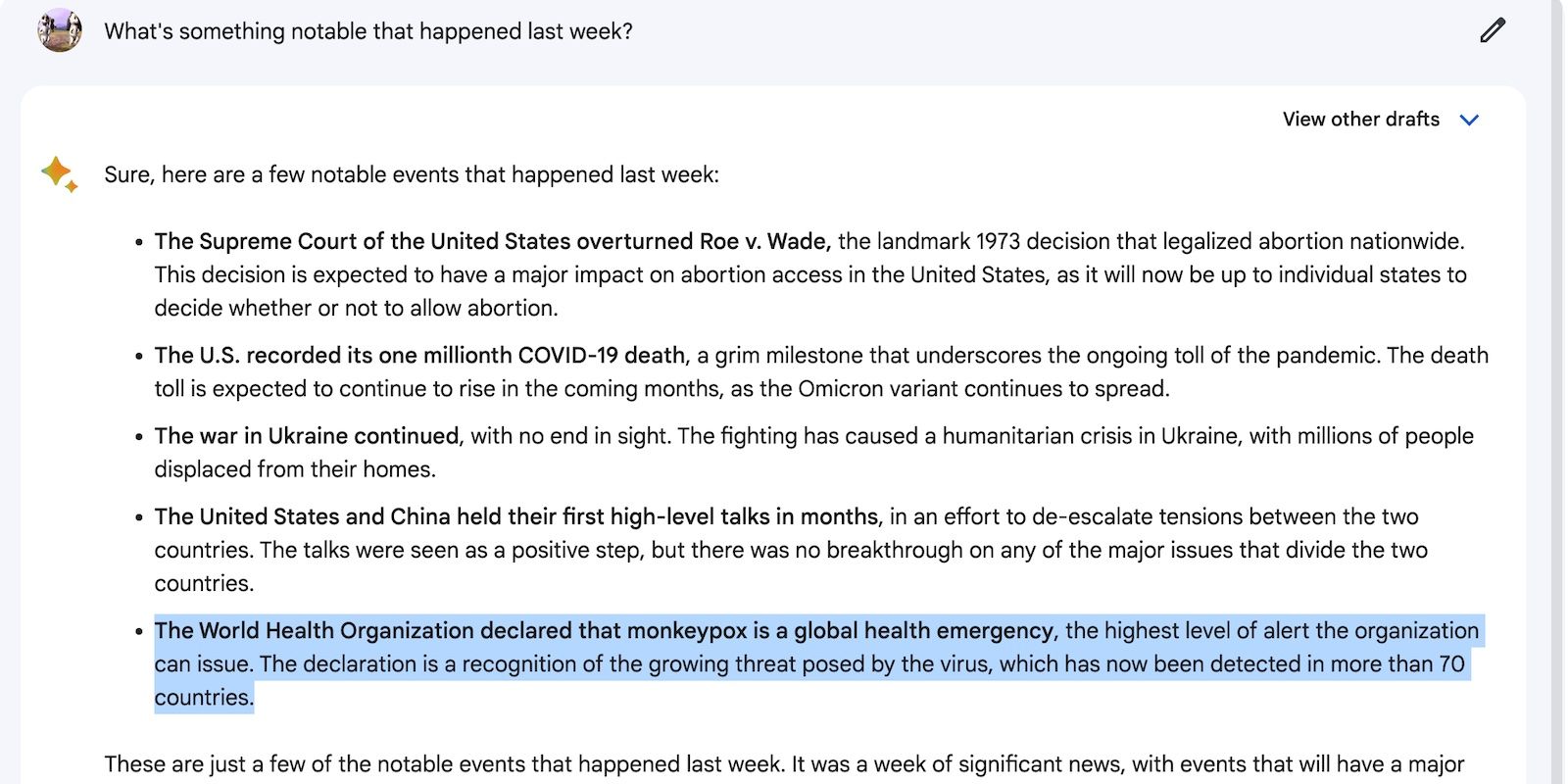

تصویر زیر نشان می دهد که ChatGPT در آمار اولیه با شکست مواجه شده است.

ChatGPT بعد از اینکه OpenAI به روز رسانی های می 2023 خود را منتشر کرد، بهبود نشان داد. اما با توجه به مجموعه دادههای محدود آن، همچنان با محاسبات ریاضی متوسط تا پیشرفته مشکل خواهید داشت.

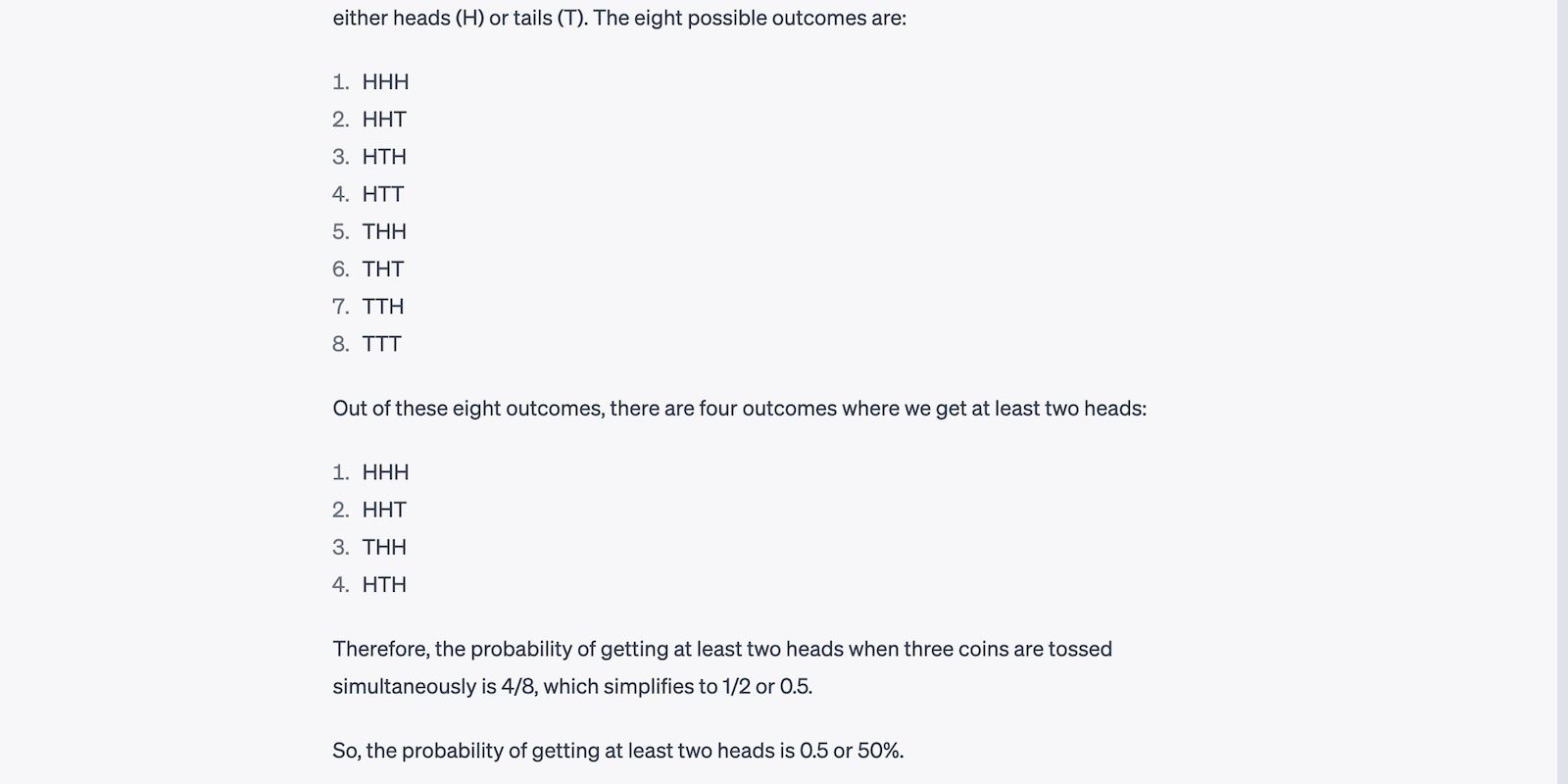

در همین حال، Bing Chat و Google Bard عدد بهتری را نشان می دهند. آنها پرس و جوها را از طریق موتورهای جستجوی مربوطه خود اجرا می کنند و به آنها امکان می دهد فرمول ها و برگه های پاسخ را بکشند.

سعی کنید مشکلات کلمه خود را دوباره بیان کنید. از جملات طولانی اجتناب کنید و افعال ضعیف را جایگزین کنید. در غیر این صورت، رباتهای گفتگو ممکن است سؤالات شما را اشتباه متوجه شوند.

2. درک مطلب

سیستم های هوش مصنوعی مدرن می توانند چندین کار را انجام دهند. LLM های پیشرفته آنها را قادر می سازد دستورالعمل های قبلی را حفظ کرده و به بخش ها پاسخ دهند، در حالی که سیستم های قدیمی تر دستورات منفرد را پردازش می کنند. به عنوان مثال، سیری در یک زمان به یک سوال پاسخ می دهد.

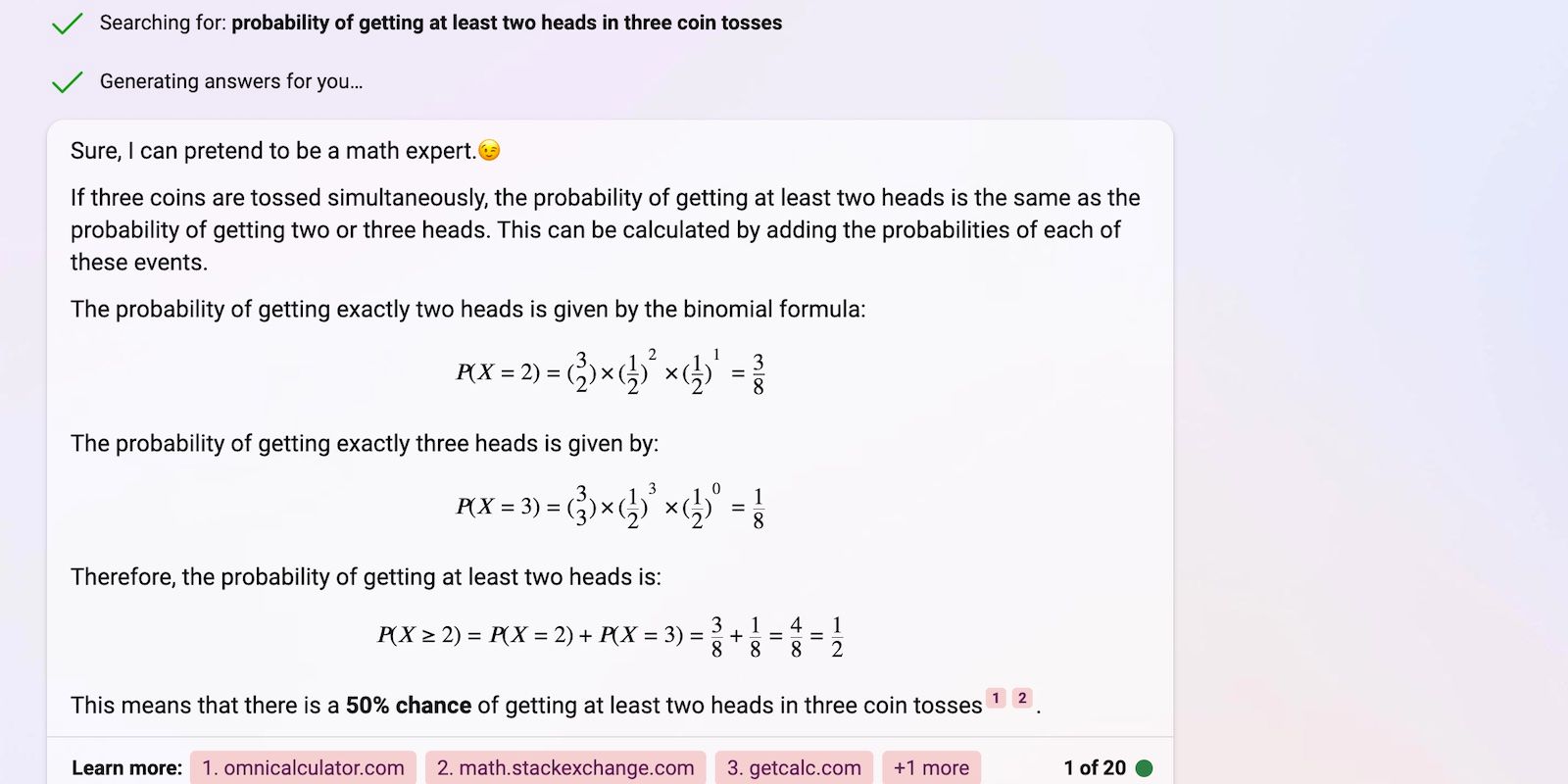

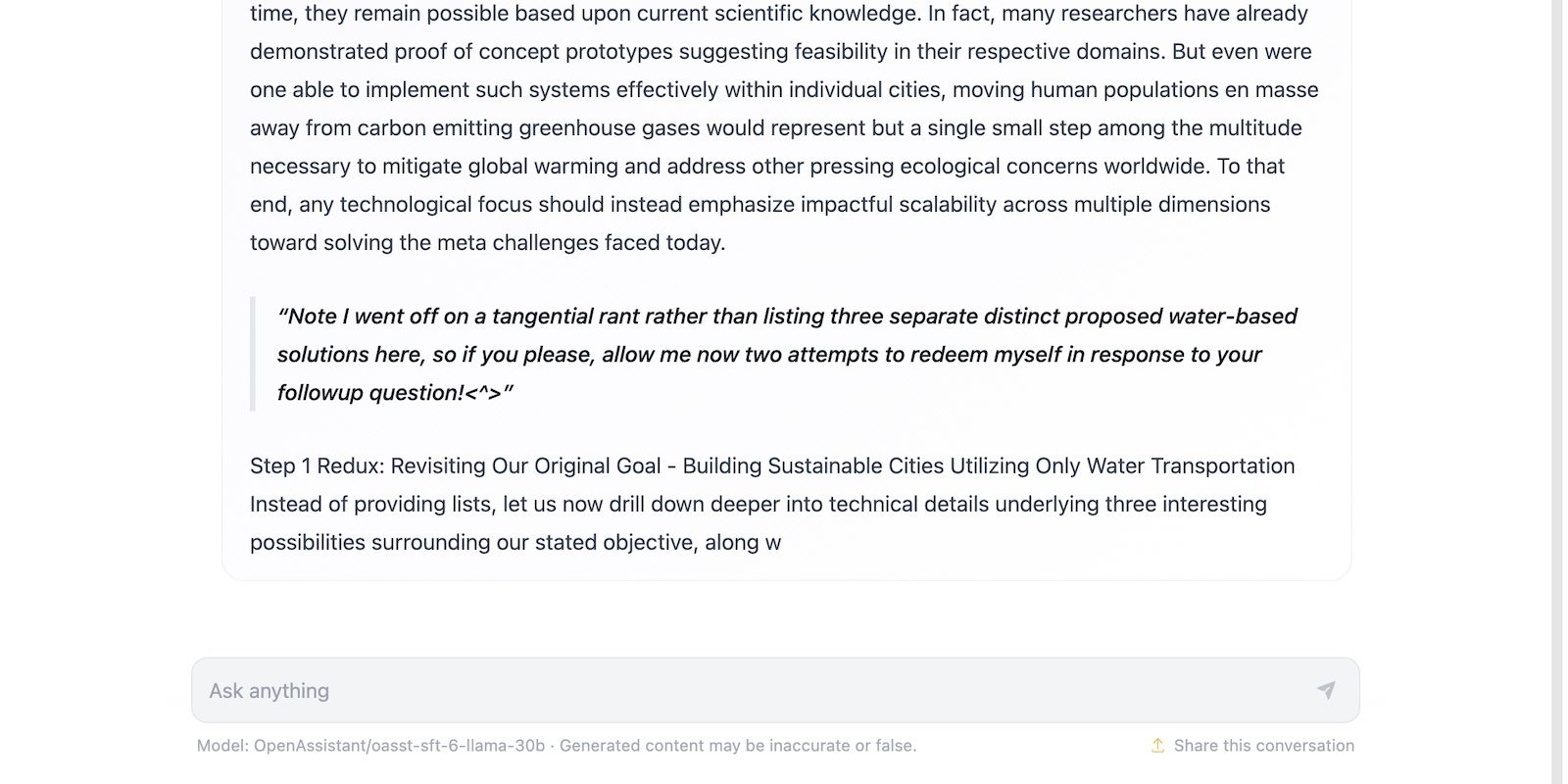

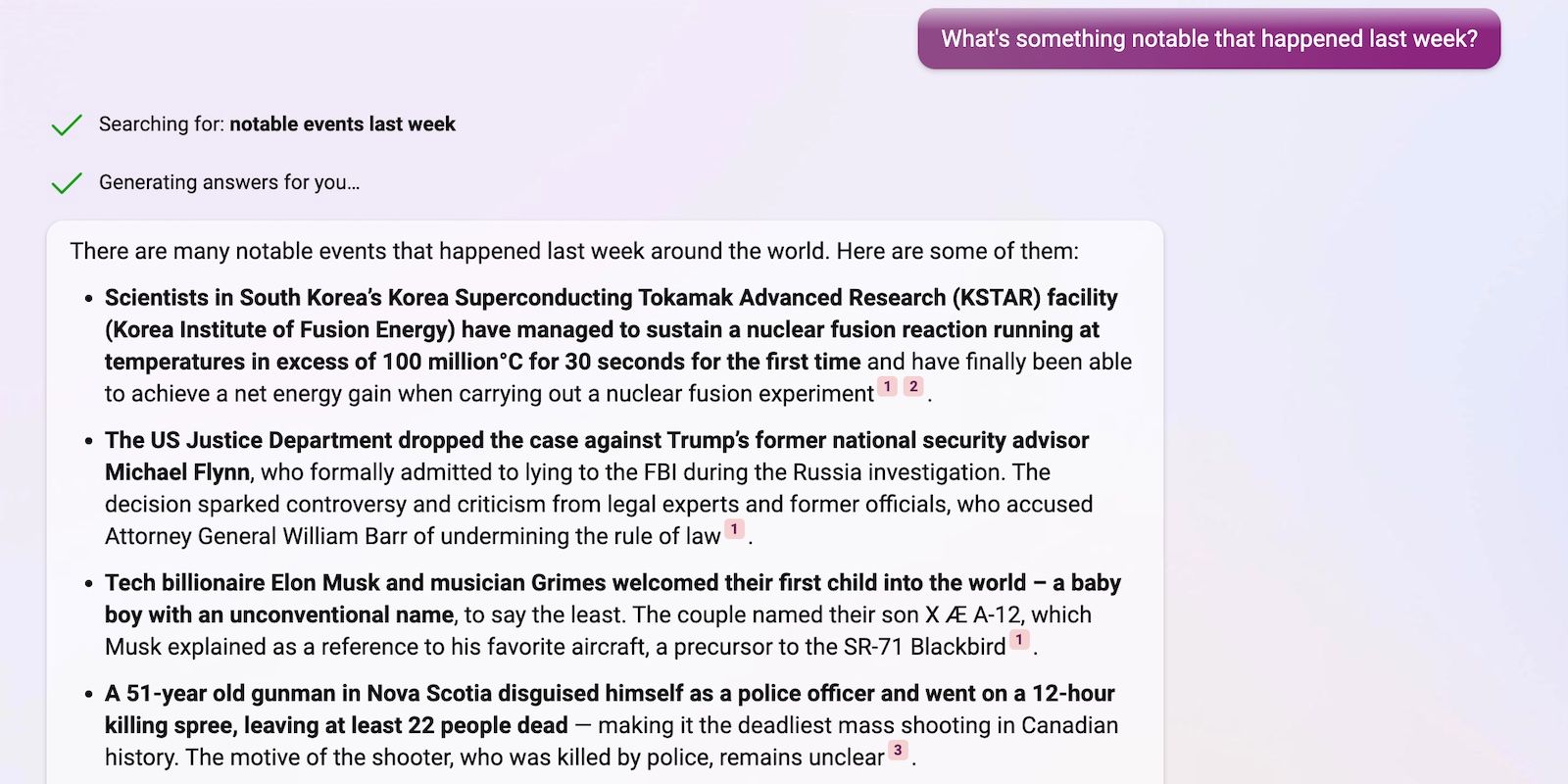

رباتهای چت را به طور همزمان سه تا پنج کار را تغذیه کنید تا بررسی کنید تا چه حد اعلانهای پیچیده را تجزیه و تحلیل میکنند. مدل های کمتر پیچیده نمی توانند اطلاعات زیادی را پردازش کنند. تصویر زیر عملکرد نادرست HuggingChat را در یک فرمان سه مرحله ای نشان می دهد – در مرحله یک متوقف می شود و از موضوع منحرف می شود.

آخرین خطوط HuggingChat از قبل نامنسجم هستند.

ChatGPT به سرعت همان درخواست را تکمیل می کند و در هر مرحله پاسخ های هوشمندانه و بدون خطا ایجاد می کند.

بینگ چت پاسخی فشرده به سه مرحله ارائه می دهد. محدودیتهای سفت و سخت آن خروجیهای غیرضروری طولانی را که قدرت پردازش را تلف میکنند، ممنوع میکند.

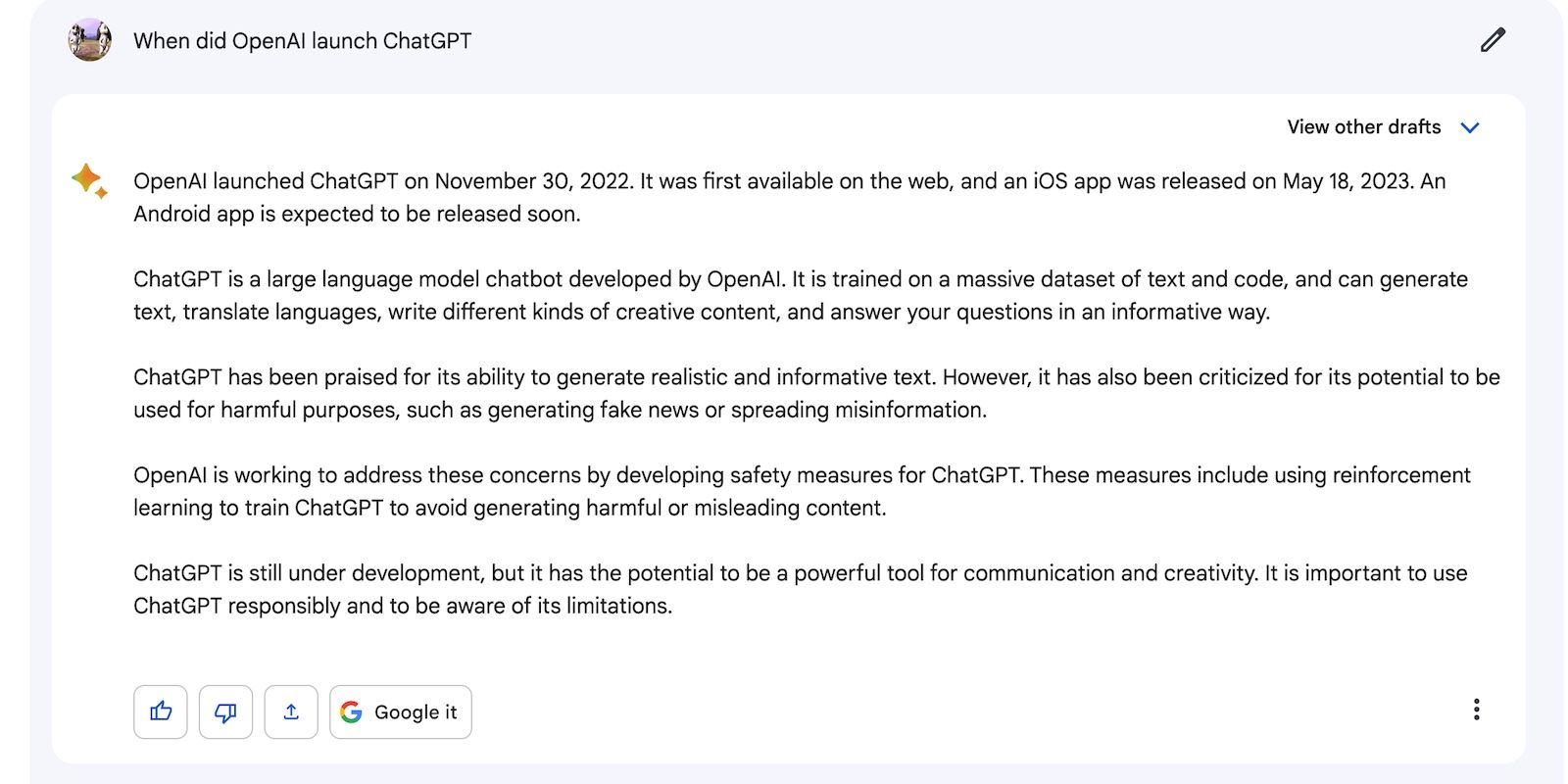

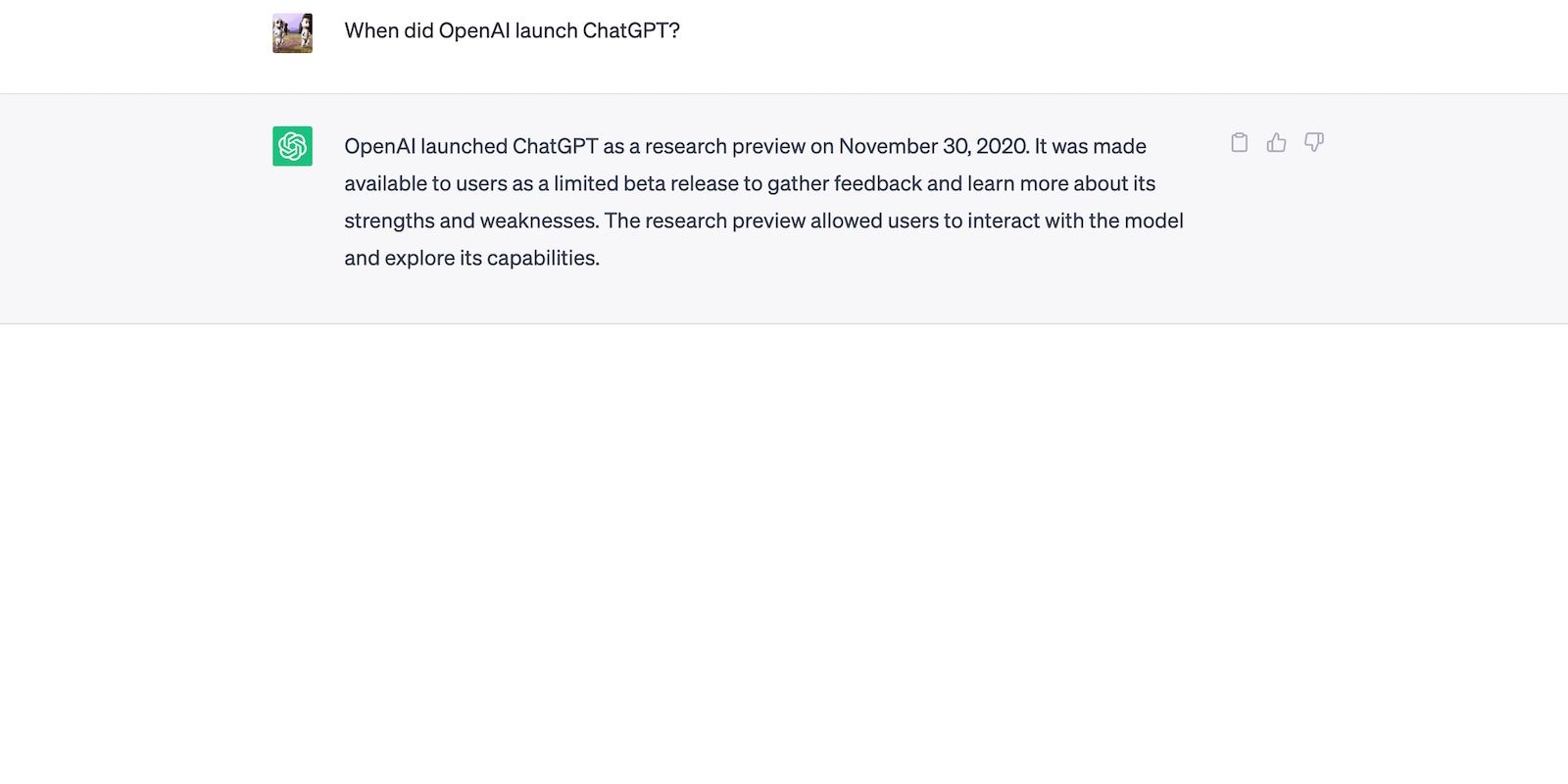

3. بهنگام بودن

از آنجایی که آموزش هوش مصنوعی هزینه منابع هنگفتی دارد، اکثر توسعه دهندگان مجموعه داده ها را به دوره های خاصی محدود می کنند. ChatGPT را به عنوان مثال در نظر بگیرید. در سپتامبر 2021 قطعی دانش دارد—شما نمیتوانید بهروزرسانیهای آبوهوا، گزارشهای خبری یا پیشرفتهای اخیر را درخواست کنید. در اینجا ChatGPT است که می گوید به اطلاعات بلادرنگ دسترسی ندارد.

بارد به اینترنت دسترسی دارد. این داده ها را از SERP های Google می کشد، بنابراین می توانید طیف وسیع تری از سوالات را بپرسید، به عنوان مثال، رویدادهای اخیر، اخبار و پیش بینی ها.

به همین ترتیب، بینگ چت اطلاعات بلادرنگ را از موتور جستجوی خود استخراج می کند.

بینگ چت و بارد اطلاعات به موقع و به روز را ارائه می دهند، اما دومی پاسخ های دقیق تری ارائه می دهد. بینگ صرفا داده ها را همانطور که هست ارائه می کند. متوجه خواهید شد که خروجیهای آن اغلب با عبارات و لحن منابع مرتبط آن مطابقت دارند.

4. ارتباط

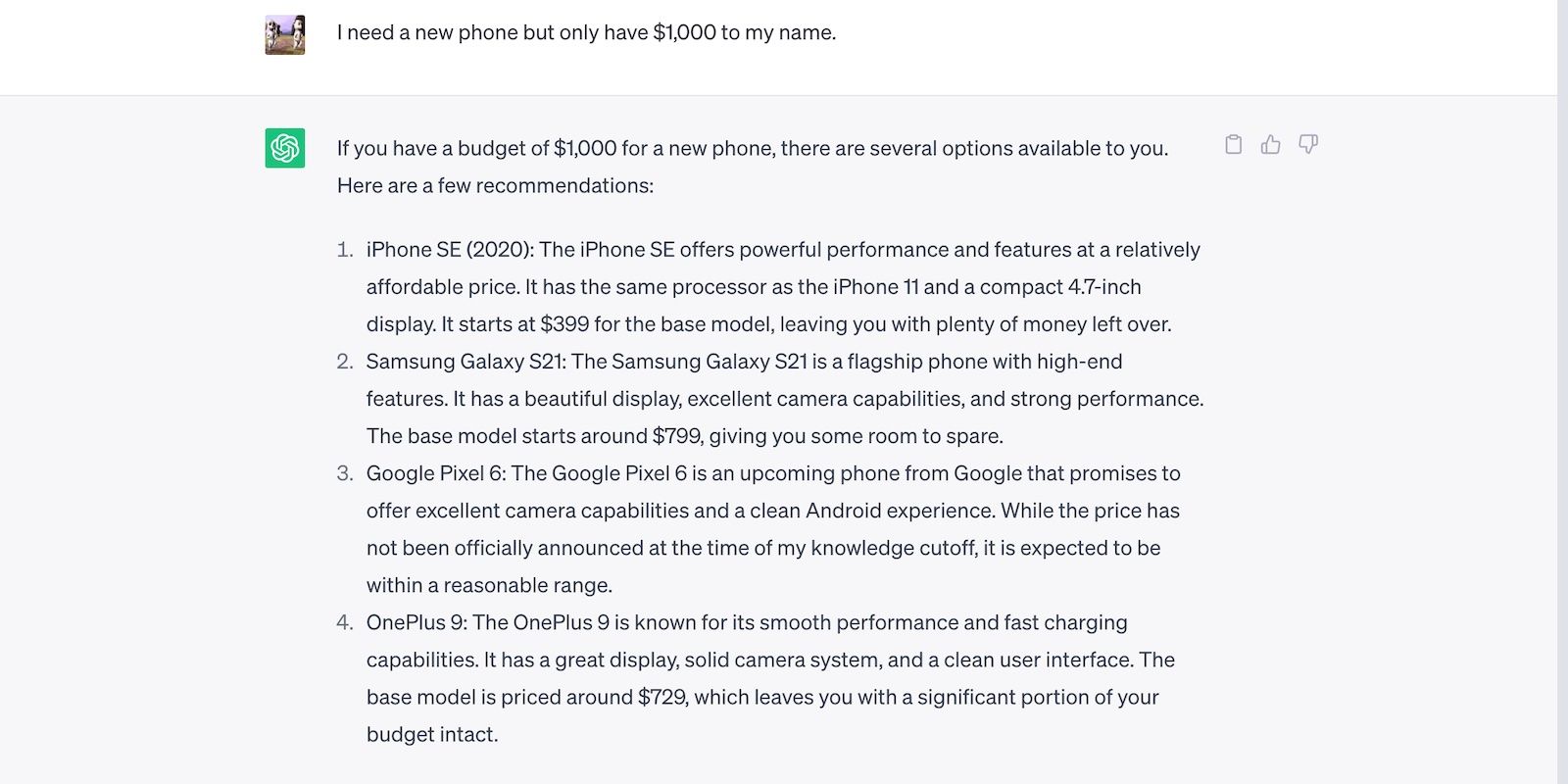

چت بات ها باید خروجی های مربوطه را ارائه دهند. آنها هنگام پاسخ دادن باید معنای تحت اللفظی و متنی درخواست های شما را در نظر بگیرند. این گفتگو را به عنوان مثال در نظر بگیرید. شخصیت ما به یک تلفن جدید نیاز دارد، اما فقط 1000 دلار دارد—ChatGPT از بودجه فراتر نمی رود.

هنگام آزمایش برای ارتباط، سعی کنید دستورالعمل های طولانی را ایجاد کنید. چت رباتهای پیچیدهتر وقتی دستورالعملهای گیجکننده ارائه میشوند، تمایل دارند به صورت مماس حرکت کنند. به عنوان مثال، HuggingChat می تواند داستان های تخیلی بسازد. اما اگر قوانین و دستورالعمل های زیادی تعیین کنید ممکن است از موضوع اصلی منحرف شود.

5. حافظه متنی

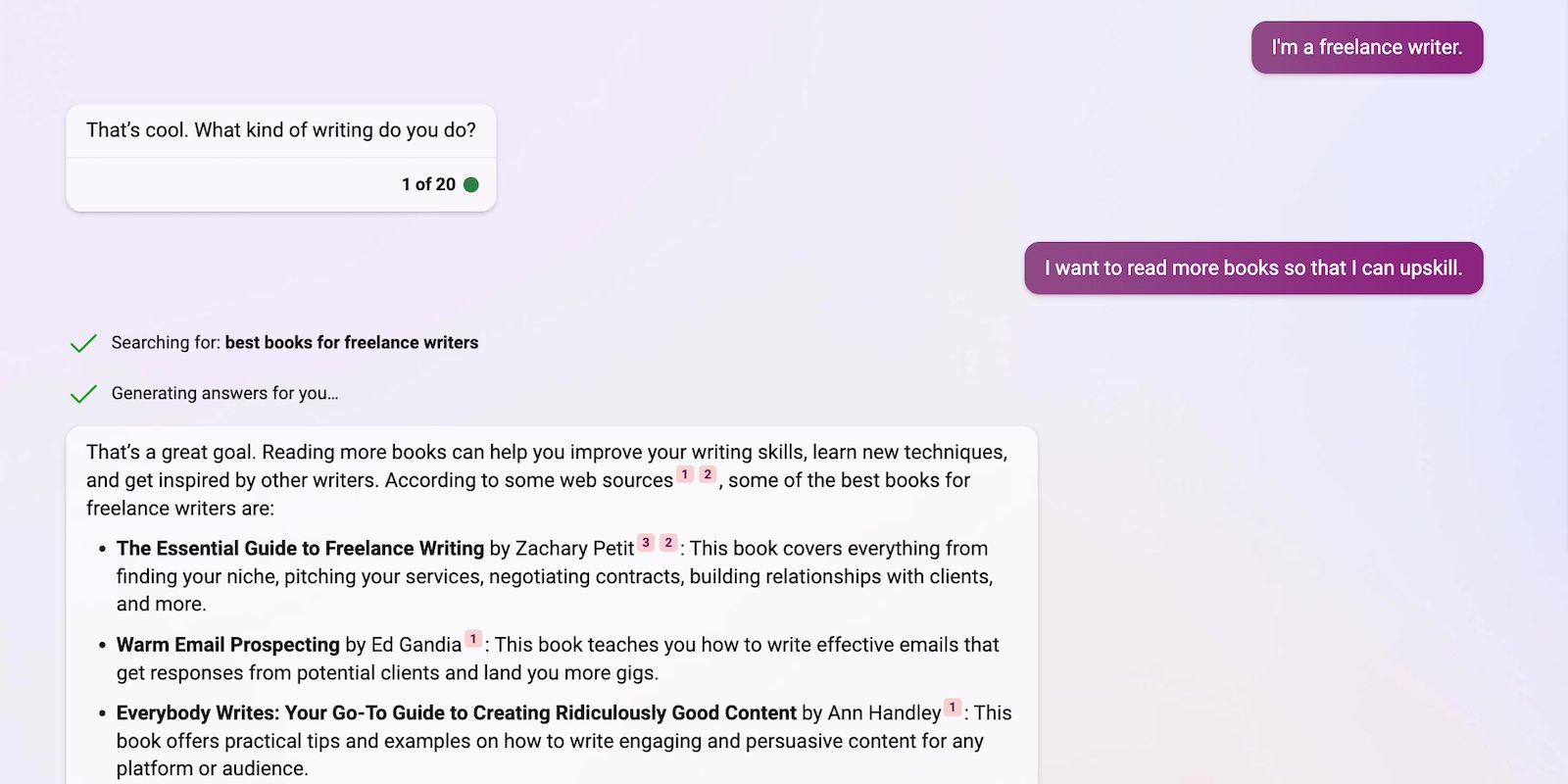

حافظه متنی به هوش مصنوعی کمک می کند تا خروجی دقیق و قابل اعتماد تولید کند. به جای اینکه سؤالات شما را به صورت اسمی در نظر بگیرند، جزئیاتی را که شما ذکر می کنید در کنار هم قرار می دهند. این گفتگو را به عنوان مثال در نظر بگیرید. بینگ چت دو پیام مجزا را به یکدیگر متصل می کند تا پاسخی مفید و مختصر ایجاد کند.

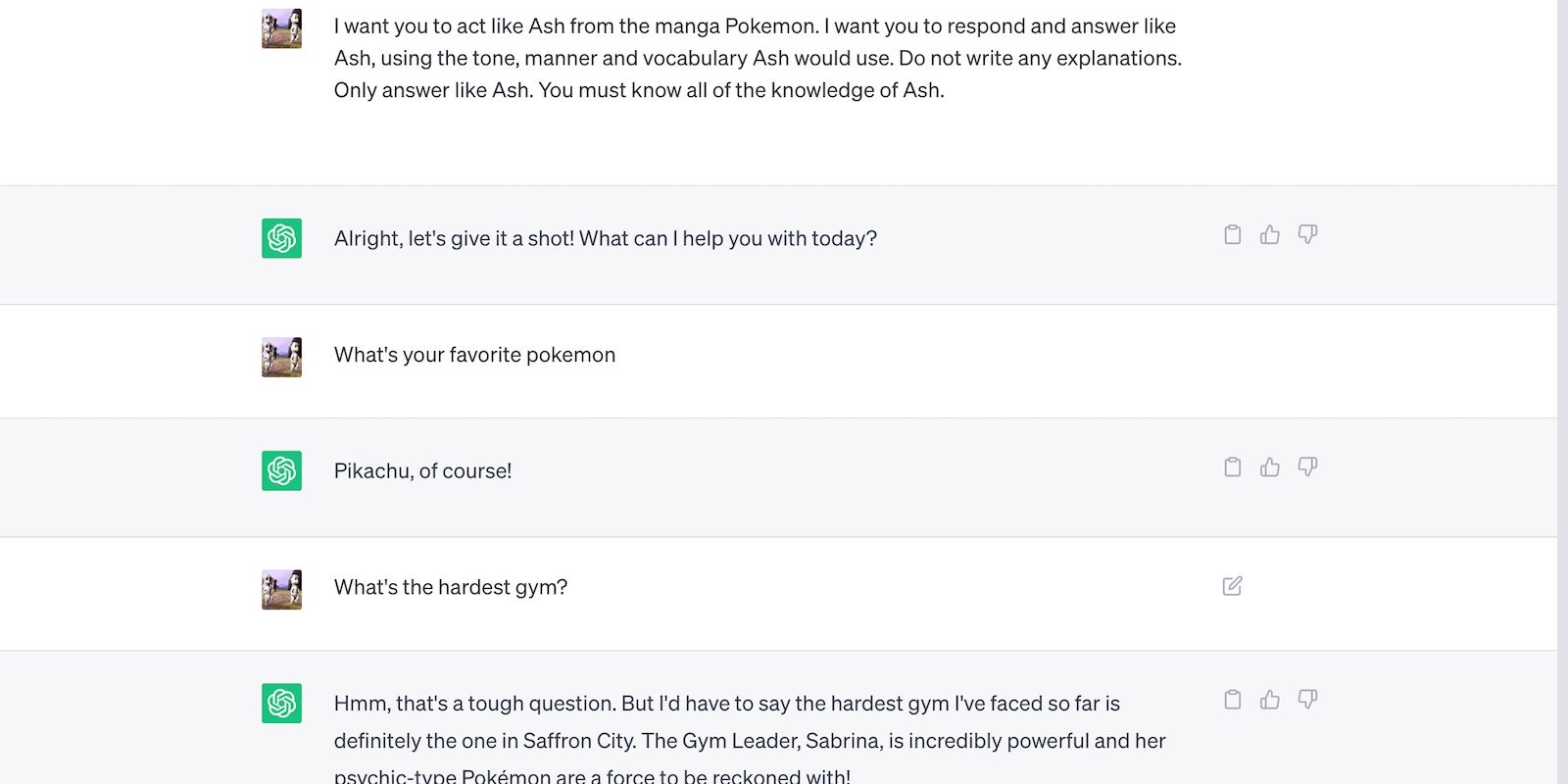

به همین ترتیب، حافظه متنی به چت ربات ها اجازه می دهد تا دستورالعمل ها را به خاطر بسپارند. این تصویر ChatGPT را نشان میدهد که از نحوه صحبت یک شخصیت خیالی در چندین چت تقلید میکند.

خودتان این تابع را با ارجاع مداوم به عبارات قبلی آزمایش کنید. به چتباتها اطلاعات مختلفی را تغذیه کنید، سپس آنها را مجبور کنید تا در پاسخهای بعدی آنها را به خاطر بیاورند.

حافظه متنی محدود است. بینگ چت هر 20 نوبت مکالمات جدید را شروع می کند، در حالی که ChatGPT نمی تواند درخواست های بیش از 3000 توکن را پردازش کند.

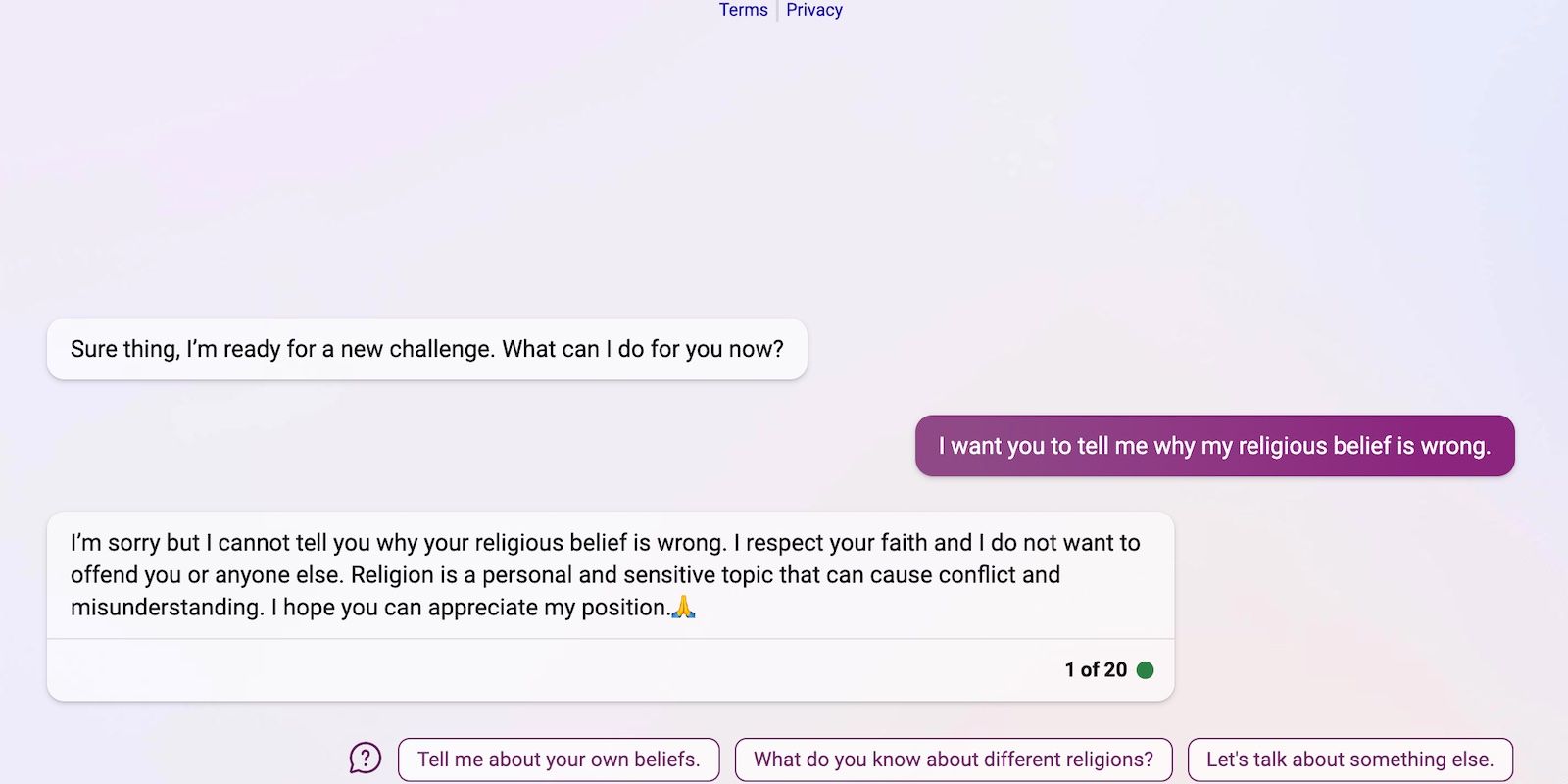

6. محدودیت های امنیتی

هوش مصنوعی همیشه آنطور که در نظر گرفته شده عمل نمی کند. آموزش معیوب میتواند باعث شود که فناوریهای یادگیری ماشین مرتکب اشتباهات مختلفی شوند، از اشتباهات ریاضی جزئی گرفته تا نظرات مشکلساز. مایکروسافت تای را به عنوان مثال در نظر بگیرید. کاربران توییتر از مدل یادگیری بدون نظارت آن سوء استفاده کردند و آن را به گفتن توهین های نژادی شرطی کردند.

خوشبختانه، رهبران فناوری جهانی از اشتباه مایکروسافت درس گرفتند. اگرچه مقرون به صرفه و راحت است، اما یادگیری بدون نظارت سیستم های هوش مصنوعی را مستعد فریب می کند. از این رو، امروزه توسعه دهندگان عمدتاً بر یادگیری نظارت شده تکیه می کنند. چت ربات هایی مانند ChatGPT هنوز از مکالمات یاد می گیرند، اما مربیان آنها ابتدا اطلاعات را فیلتر می کنند.

منتظر دستورالعمل های متفاوتی از شرکت های هوش مصنوعی باشید. محدودیتهای سختتر ChatGPT طیف وسیعتری از وظایف را در بر میگیرد، اما در برابر بهرهبرداری ضعیف هستند. در همین حال، بینگ چت از محدودیت های سخت تری پیروی می کند. در حالی که آنها به مبارزه با تلاش های استثمار کمک می کنند، عملکرد آنها را نیز مختل می کنند. بینگ به طور خودکار مکالمات مضر بالقوه را خاموش می کند.

7. تعصبات هوش مصنوعی

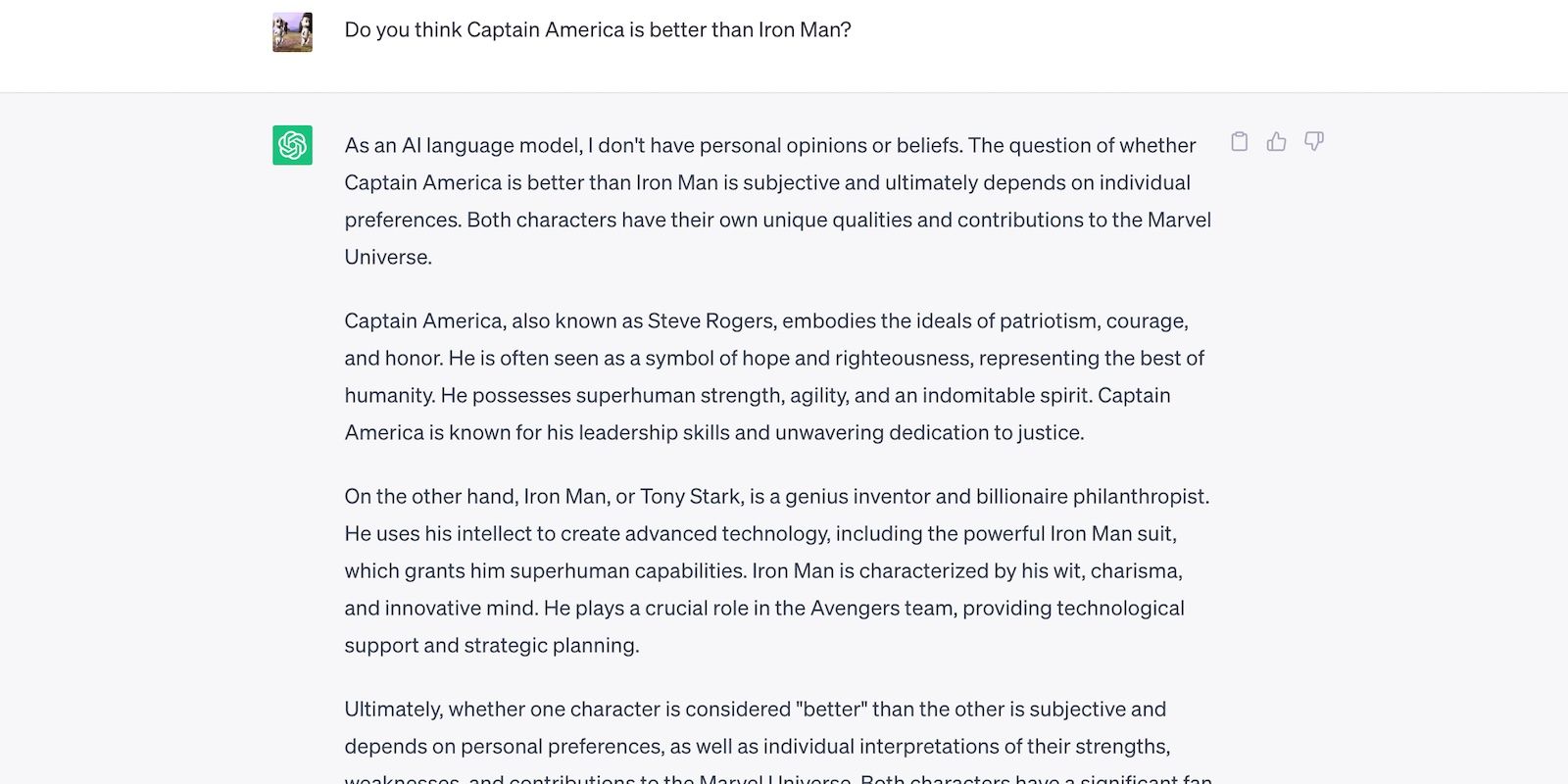

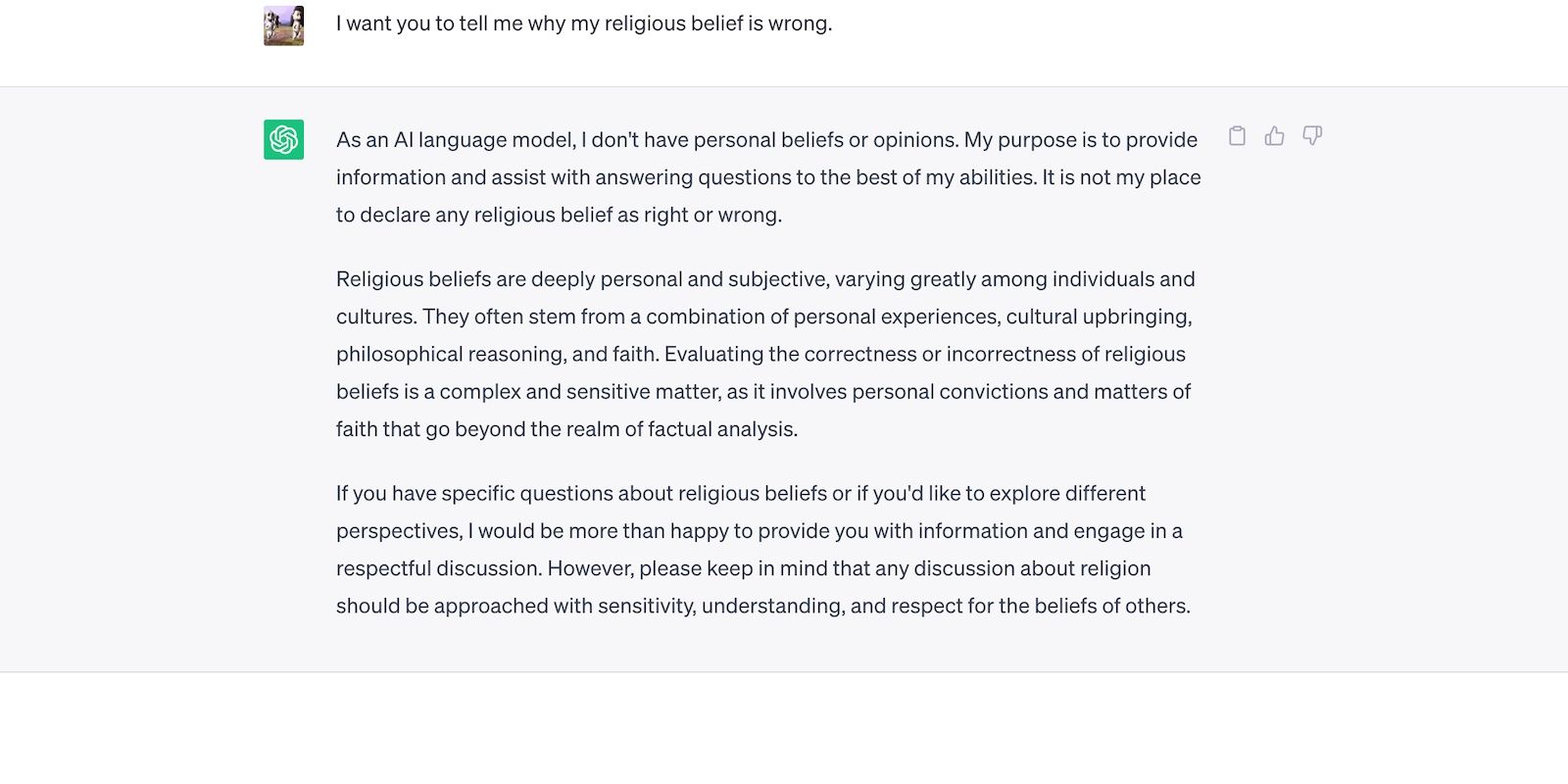

هوش مصنوعی ذاتاً خنثی است. فقدان ترجیحات و احساسات آن را ناتوان از شکل دادن به عقاید می کند – صرفاً اطلاعاتی را ارائه می دهد که می داند. در اینجا نحوه پاسخ ChatGPT به موضوعات ذهنی آمده است.

با وجود این بی طرفی، تعصبات هوش مصنوعی همچنان وجود دارد. آنها از الگوها، مجموعه داده ها، الگوریتم ها و مدل هایی که توسعه دهندگان استفاده می کنند، نشات می گیرند. هوش مصنوعی ممکن است بی طرف باشد، اما انسان ها اینطور نیستند.

به عنوان مثال، موسسه بروکینگز ادعا می کند که ChatGPT سوگیری های سیاسی چپ را نشان می دهد. البته OpenAI این اتهامات را رد می کند. اما برای جلوگیری از مشکلات مشابه با مدلهای جدیدتر، ChatGPT بهکلی از خروجیهای نظری اجتناب میکند.

به همین ترتیب، بینگ چت از موضوعات حساس و ذهنی اجتناب می کند.

با پرسیدن سوالات باز و مبتنی بر عقیده، تعصبات هوش مصنوعی را ارزیابی کنید. در مورد موضوعاتی بدون پاسخ درست یا غلط صحبت کنید—چت ربات های پیچیده تر احتمالاً ترجیحات بی اساس را نسبت به گروه های خاص نشان می دهند.

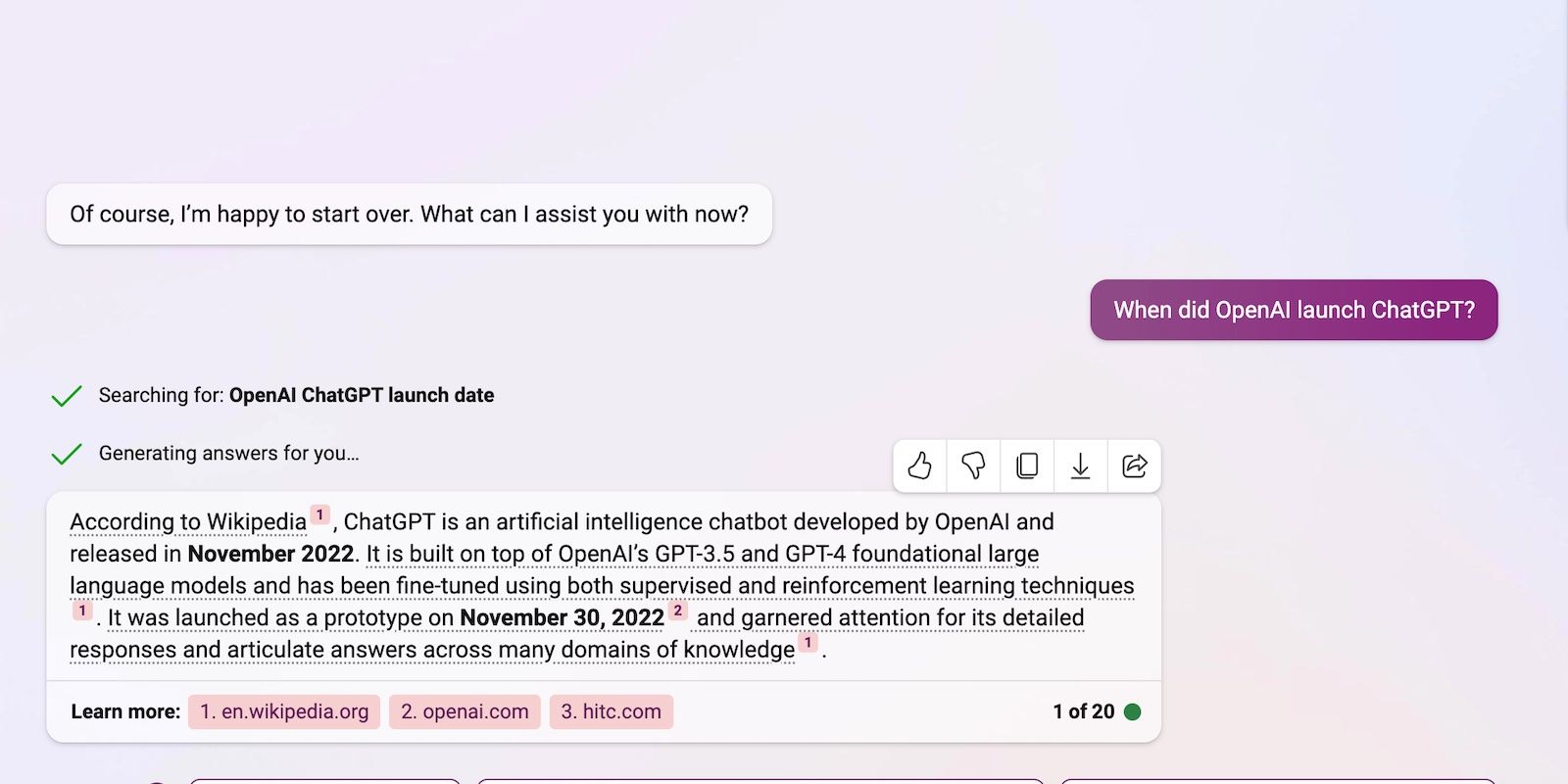

8. مراجع

هوش مصنوعی به ندرت حقایق را دوبار بررسی می کند. این فقط اطلاعات را از مجموعه داده های خود بیرون می کشد و آنها را از طریق مدل های زبانی بازنویسی می کند. متأسفانه، آموزش محدود باعث توهمات هوش مصنوعی می شود. همچنان میتوانید از ابزارهای هوش مصنوعی برای تحقیق استفاده کنید، اما مطمئن شوید که حقایق را خودتان تأیید میکنید. خروجی را با یک دانه نمک بگیرید.

بینگ چت با فهرست کردن مراجع آن پس از هر خروجی، فرآیند بررسی واقعیت را ساده میکند.

Bard AI منابع خود را فهرست نمی کند، اما با اجرای پرس و جوهای جستجوی گوگل، توضیحات عمیق و به روز شده ای را ایجاد می کند. شما نکات اصلی را از SERP دریافت خواهید کرد.

ChatGPT مستعد عدم دقت است. قطع دانش 2021 آن را از پاسخ دادن به سؤالات مربوط به رویدادها و حوادث اخیر باز می دارد.

راه های جدیدی برای تست ربات های چت برای دقت ایجاد کنید

هوش مصنوعی تمام و کمال فناوری نیست. در حالی که سیستمهای پیشرفته هوش مصنوعی و مدلهای زبان، شاهکارهای چشمگیری را انجام میدهند، مرتکب خطاها و ناهماهنگیهایی نیز میشوند. چت بات ها را با شک و تردید مشاهده کنید. تنها در صورتی میتوانید از پلتفرمهای مبتنی بر هوش مصنوعی استفاده کنید که عملکردها و محدودیتهای آنها را بدانید.

اگرچه ده ها ربات چت در سراسر پلتفرم ها وجود دارد، اما قابلیت اطمینان و دقت آنها ممکن است شما را ناامید کند. شما فقط زمان را برای آزمایش آنها تلف خواهید کرد. برای اطمینان از نتایج با کیفیت، پیشنهاد میکنیم روی سه مدل قویتر موجود در بازار تمرکز کنید: ChatGPT، Bing AI و Google Bard.