الگوریتمهای یادگیری ماشینی برای آسانتر کردن زندگی و بهبود سیستمها طراحی شدهاند، اما میتوانند با عواقب بدی دچار مشکل شوند.

هوش مصنوعی و یادگیری ماشین بسیاری از پیشرفتهایی را که امروزه در صنعت فناوری میبینیم، ایجاد میکنند. اما چگونه به ماشین ها توانایی یادگیری داده می شود؟ علاوه بر این، نحوه انجام این کار چگونه منجر به عواقب ناخواسته می شود؟

در اینجا توضیح سریع ما در مورد نحوه عملکرد الگوریتمهای یادگیری ماشین، همراه با چند نمونه از یادگیری ماشینی اشتباه است.

الگوریتم های یادگیری ماشینی چیست؟

یادگیری ماشینی شاخه ای از علوم کامپیوتر است که بر روی دادن توانایی هوش مصنوعی برای یادگیری وظایف تمرکز دارد. این شامل توسعه تواناییها بدون کدنویسی صریح AI توسط برنامهنویسان برای انجام این کارها میشود. در عوض، هوش مصنوعی قادر است از داده ها برای آموزش خود استفاده کند.

برنامه نویسان از طریق الگوریتم های یادگیری ماشین به این امر دست می یابند. این الگوریتمها مدلهایی هستند که رفتار یادگیری هوش مصنوعی بر اساس آنها است. الگوریتم ها، در ارتباط با مجموعه داده های آموزشی، هوش مصنوعی را قادر به یادگیری می کنند.

یک الگوریتم معمولاً مدلی را ارائه می دهد که هوش مصنوعی می تواند از آن برای حل یک مسئله استفاده کند. به عنوان مثال، یادگیری نحوه تشخیص تصاویر گربه در مقابل سگ. هوش مصنوعی مدل تعیین شده توسط الگوریتم را در مجموعه داده ای که شامل تصاویر گربه ها و سگ ها است، اعمال می کند. با گذشت زمان، هوش مصنوعی یاد میگیرد که چگونه گربهها را از سگها بهطور دقیقتر و آسانتر و بدون دخالت انسان تشخیص دهد.

یادگیری ماشینی فناوری هایی مانند موتورهای جستجو، دستگاه های خانه هوشمند، خدمات آنلاین و ماشین های مستقل را بهبود می بخشد. این نشان میدهد که چگونه نتفلیکس میداند از کدام فیلمها بیشتر لذت میبرید و چگونه سرویسهای پخش موسیقی میتوانند لیستهای پخش را توصیه کنند.

اما در حالی که یادگیری ماشینی میتواند زندگی ما را بسیار آسانتر کند، میتواند عواقب غیرمنتظرهای نیز داشته باشد.

7 باری که یادگیری ماشین اشتباه شد

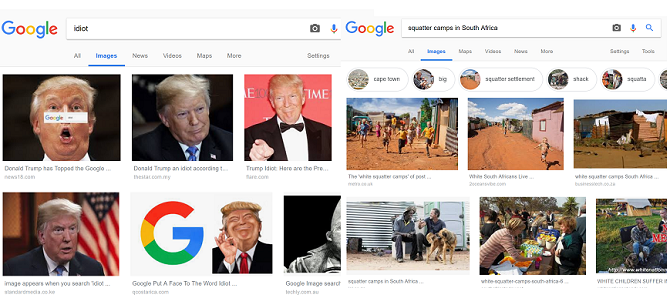

1. نتایج نادرست جستجوی تصویر گوگل

جستجوی گوگل پیمایش در وب را بسیار آسان کرده است. الگوریتم موتور هنگام به دست آوردن نتایج، موارد مختلفی مانند کلمات کلیدی و نرخ پرش را در نظر می گیرد. اما الگوریتم از ترافیک کاربر نیز یاد می گیرد که می تواند کیفیت نتایج جستجو را با مشکل مواجه کند.

این در هیچ کجا بیشتر از نتایج تصویر آشکار نیست. از آنجایی که صفحاتی که ترافیک بالایی دریافت میکنند، احتمالاً تصاویرشان نمایش داده میشود، داستانهایی که تعداد زیادی از کاربران را به خود جذب میکنند، اغلب در اولویت قرار میگیرند.

به عنوان مثال، نتایج جستجوی تصویر برای «اردوگاههای اسکوتر در آفریقای جنوبی» زمانی که مشخص شد که عمدتاً سفیدپوستهای آفریقای جنوبی را نشان میدهد، جنجال ایجاد کرد. این در حالی است که آمارها نشان می دهد که اکثریت قریب به اتفاق کسانی که در خانه های غیررسمی مانند کلبه ها زندگی می کنند سیاه پوستان آفریقای جنوبی هستند.

فاکتورهای استفاده شده در الگوریتم گوگل به این معنی است که کاربران اینترنت می توانند نتایج را دستکاری کنند. به عنوان مثال، کمپینی از سوی کاربران بر نتایج جستجوی تصویر گوگل تأثیر گذاشت تا جایی که جستجوی عبارت «احمق» تصاویری از دونالد ترامپ، رئیسجمهور ایالات متحده را نشان میدهد.

2. ربات مایکروسافت به نازی تبدیل شد

به توییتر اعتماد کنید تا یک چت ربات خوش نیت و یادگیری ماشینی را خراب کند. این همان چیزی است که در یک روز پس از انتشار چت ربات بدنام مایکروسافت Tay اتفاق افتاد.

تای الگوهای زبانی یک دختر نوجوان را تقلید کرد و از طریق تعاملاتش با سایر کاربران توییتر یاد گرفت. با این حال، زمانی که شروع به اشتراک گذاری اظهارات نازی ها و توهین های نژادی کرد، او به یکی از بدنام ترین اشتباهات هوش مصنوعی تبدیل شد. به نظر می رسد که ترول ها از یادگیری ماشینی هوش مصنوعی علیه آن استفاده کرده اند و آن را با تعاملات مملو از تعصب پر کرده اند.

چندی بعد، مایکروسافت Tay را برای همیشه آفلاین کرد.

3. مشکلات تشخیص چهره هوش مصنوعی

هوش مصنوعی تشخیص چهره اغلب به دلایل اشتباه، مانند داستان هایی در مورد تشخیص چهره و نگرانی های مربوط به حفظ حریم خصوصی، تیتر خبرها می شود. اما این هوش مصنوعی هنگام تلاش برای تشخیص افراد رنگین پوست باعث نگرانی های زیادی نیز شد.

در سال 2015، کاربران متوجه شدند که Google Photos برخی از سیاه پوستان را به عنوان گوریل دسته بندی می کند. در سال 2018، تحقیقات ACLU نشان داد که نرم افزار شناسایی چهره آمازون Rekognition، 28 عضو کنگره ایالات متحده را به عنوان مظنون پلیس شناسایی کرده است، با نتایج مثبت کاذب که به طور نامتناسبی بر افراد رنگین پوست تأثیر می گذارد.

رویداد دیگر مربوط به نرمافزار Face ID اپل بود که دو زن مختلف چینی را بهعنوان یک شخص به اشتباه شناسایی کرد. در نتیجه، همکار صاحب آیفون X می تواند قفل گوشی را باز کند.

در همین حال، جوی بولاموینی، محقق MIT به یاد میآورد که هنگام کار بر روی فناوری تشخیص چهره، اغلب نیاز به پوشیدن ماسک سفید داشت تا بتواند او را تشخیص دهد. برای حل مسائلی مانند این، Buolamwini و سایر متخصصان فناوری اطلاعات به این موضوع و نیاز به مجموعه دادههای فراگیرتر برای آموزش هوش مصنوعی توجه میکنند.

4. دیپ فیک مورد استفاده برای حقه

در حالی که مردم مدتهاست از فتوشاپ برای ایجاد تصاویر جعلی استفاده میکنند، یادگیری ماشینی این را به سطح جدیدی میبرد. نرمافزاری مانند FaceApp به شما امکان میدهد سوژهها را از یک ویدیو به ویدیوی دیگر تغییر دهید.

اما بسیاری از افراد از این نرم افزار برای مصارف مخرب مختلف، از جمله قرار دادن چهره افراد مشهور در ویدیوهای بزرگسالان یا تولید ویدیوهای فریبنده، سوء استفاده می کنند. در همین حال، کاربران اینترنت به بهبود این فناوری کمک کرده اند تا تشخیص ویدیوهای واقعی از جعلی به طور فزاینده ای دشوار شود. در نتیجه، این نوع هوش مصنوعی از نظر انتشار اخبار جعلی و حقهبازی بسیار قدرتمند میشود.

برای نشان دادن قدرت این فناوری، جردن پیل، کارگردان و جونا پرتی، مدیر عامل BuzzFeed، ویدئویی ساختند که به نظر میرسد باراک اوباما، رئیسجمهور سابق ایالات متحده، یک PSA درباره قدرت دیپفیک ارائه میدهد.

5. ظهور ربات های توییتر

رباتهای توییتر در ابتدا برای خودکارسازی مواردی مانند پاسخهای خدمات مشتری برای برندها ایجاد شدند. اما این فناوری اکنون دلیل اصلی نگرانی است. در واقع، تحقیقات تخمین زده است که تا 48 میلیون کاربر در توییتر در واقع ربات های هوش مصنوعی هستند.

بسیاری از حسابهای ربات به جای استفاده از الگوریتمها برای دنبال کردن هشتگهای خاص یا پاسخ به سؤالات مشتریان، سعی میکنند از افراد واقعی تقلید کنند. این «افراد» سپس حقهها را تبلیغ میکنند و به انتشار اخبار جعلی کمک میکنند.

موجی از ربات های توییتر حتی تا حدی بر افکار عمومی در مورد برگزیت و انتخابات ریاست جمهوری 2016 آمریکا تأثیر گذاشت. خود توییتر اعتراف کرد که حدود 50000 ربات ساخت روسیه را که در مورد انتخابات پست میکردند، کشف کرد.

ربات ها همچنان به این سرویس آسیب می رسانند و اطلاعات نادرست را منتشر می کنند. این مشکل به قدری گسترده است که حتی بر ارزش گذاری شرکت نیز تأثیر می گذارد.

6. کارمندان می گویند هوش مصنوعی آمازون تصمیم گرفت مردان را استخدام کند

در اکتبر 2018، رویترز گزارش داد که آمازون مجبور شد ابزار استخدامی را پس از اینکه هوش مصنوعی نرم افزار تصمیم گرفت که نامزدهای مرد ترجیحی هستند را کنار بگذارد.

کارمندانی که می خواستند نامشان فاش نشود به رویترز آمدند تا در مورد کار خود در این پروژه صحبت کنند. توسعه دهندگان از هوش مصنوعی می خواستند تا بر اساس رزومه آنها بهترین نامزدها را برای یک شغل شناسایی کند. با این حال، افراد درگیر در این پروژه به زودی متوجه شدند که هوش مصنوعی نامزدهای زن را جریمه می کند. آنها توضیح دادند که هوش مصنوعی از رزومه های دهه گذشته که بیشتر آن ها از مردان بود، به عنوان مجموعه داده آموزشی خود استفاده می کرد.

در نتیجه، هوش مصنوعی شروع به فیلتر کردن CV ها بر اساس کلمه کلیدی “زنان” کرد. کلمه کلیدی آنها در رزومه تحت فعالیت هایی مانند “کاپیتان باشگاه شطرنج زنان” ظاهر شد. در حالی که توسعه دهندگان برای جلوگیری از جریمه شدن رزومه های زنانه هوش مصنوعی را تغییر دادند، آمازون در نهایت این پروژه را کنار گذاشت.

7. محتوای نامناسب در YouTube Kids

YouTube Kids ویدیوهای احمقانه و عجیب زیادی دارد که برای سرگرم کردن کودکان طراحی شده است. اما مشکل ویدیوهای اسپم که الگوریتم پلتفرم را دستکاری می کنند نیز دارد.

این ویدیوها بر اساس برچسب های محبوب هستند. از آنجایی که کودکان خردسال بینندگان بسیار دقیقی نیستند، ویدیوهای ناخواسته با استفاده از این کلمات کلیدی میلیون ها بازدید را جذب می کنند. هوش مصنوعی به طور خودکار برخی از این ویدیوها را با استفاده از عناصر پویانمایی استوک، بر اساس برچسبهای پرطرفدار تولید میکند. حتی زمانی که فیلم ها توسط انیماتورها ساخته می شوند، عناوین آنها به طور خاص برای پر کردن کلمات کلیدی ایجاد می شود.

این کلمات کلیدی به دستکاری الگوریتم یوتیوب کمک می کند تا در نهایت به توصیه ها ختم شود. مقدار قابل توجهی از محتوای نامناسب در فیدهای کودکان با استفاده از برنامه YouTube Kids ظاهر شد. این شامل محتوایی میشود که خشونت، ترس و وحشت و محتوای جنسی را به تصویر میکشد.

چرا یادگیری ماشین اشتباه می شود؟

دو دلیل عمده وجود دارد که یادگیری ماشین منجر به عواقب ناخواسته می شود: داده ها و افراد. از نظر دادهها، شعار “آشغال در، آشغال بیرون” اعمال میشود. اگر دادههایی که به یک هوش مصنوعی داده میشود محدود، مغرضانه یا با کیفیت پایین باشد. نتیجه یک هوش مصنوعی با دامنه یا سوگیری محدود است.

اما حتی اگر برنامهنویسان دادهها را به درستی دریافت کنند، مردم میتوانند آچاری را در کار بیاندازند. سازندگان نرم افزار اغلب متوجه نمی شوند که چگونه افراد ممکن است از فناوری به طور مخرب یا برای اهداف خودخواهانه استفاده کنند. دیپ فیک از فناوری استفاده شده برای بهبود جلوه های ویژه در سینما به دست آمد.

چیزی که هدفش ارائه سرگرمی های فراگیرتر است، در صورت استثمار، زندگی مردم را نیز نابود می کند.

افرادی هستند که در جهت بهبود پادمان های مربوط به فناوری یادگیری ماشین برای جلوگیری از استفاده مخرب کار می کنند. اما فن آوری در حال حاضر اینجاست. در همین حال، بسیاری از شرکت ها اراده لازم را برای جلوگیری از سوء استفاده از این پیشرفت ها نشان نمی دهند.

الگوریتم های یادگیری ماشین می توانند به ما کمک کنند

وقتی متوجه میشوید که یادگیری ماشین و هوش مصنوعی چقدر از انتظارات کمتر است، ممکن است کمی غمانگیز به نظر برسد. اما همچنین از بسیاری جهات به ما کمک می کند — نه فقط از نظر راحتی، بلکه در بهبود زندگی ما به طور کلی.

اگر کمی در مورد تأثیر مثبت هوش مصنوعی و یادگیری ماشینی تردید دارید، در مورد راه هایی که هوش مصنوعی با جرایم سایبری و هکرها برای بازگرداندن امید مبارزه می کند، بیابید.